- Investment

- 科学论坛

-

Program

- Recruitment

- Center

News Message

LLM 最新论文

- by wittx 2023-07-16

P1 07-06 Focused Transformer: 对比训练用于上下文扩展

- Title: Focused Transformer: Contrastive Training for Context Scaling

- 论文简介: 本文由IDEAS NCBR、Polish Academy of Sciences、University of Warsaw和Google DeepMind的作者提出了一种名为Focused Transformer (FOT)的方法,通过对比学习的训练过程,解决了大规模语言模型中有效上下文长度的限制问题。

- Authors: Szymon Tworkowski, Konrad Staniszewski, Mikołaj Pacek, Yuhuai Wu, Henryk Michalewski, Piotr Miło´s

- Affiliation: Szymon Tworkowski: University of Warsaw

- Keywords: large language models, context scaling, attention layer, external memory, distraction issue

- Paper: Link Github: None

- 论文总结:

- (1): 本文的研究背景是大规模语言模型中有效上下文长度的限制问题。

- (2): 过去的方法主要集中在减少注意力计算的复杂度,如Transformer-XL、Longformer、BigBird等。然而,这些方法在处理多文档情况下存在分散注意力的问题。本文提出的方法通过对比学习的训练过程,解决了这一问题,并能够扩展模型的有效上下文长度。

- (3): 本文提出的Focused Transformer (FOT)方法通过训练过程中的对比学习,增强了(key, value)空间的结构,从而扩展了上下文长度。该方法可以应用于现有模型的微调,无需修改模型的架构。

- (4): 本文通过对3B和7B OpenLLaMA模型的微调,展示了LONGLLAMA2模型在需要长上下文的任务上的改进。此外,本文还证明了LONGLLAMA模型在256k上下文长度的passkey检索任务上的良好表现。该方法的创新点在于通过对比学习的训练过程,解决了分散注意力的问题,并能够扩展模型的上下文长度。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文提出了一种名为Focused Transformer (FOT)的方法,通过对比学习的训练过程,增强了(key, value)空间的结构,从而扩展了上下文长度。

b. 方法的详细步骤: (1). Focused Transformer (FOT)是一种简单的插件式Transformer模型扩展方法,可以用于训练新模型或对现有模型进行微调,以实现更长的上下文。

(2). FOT使用了内存注意力层和跨批次训练过程。内存注意力层使模型能够在推理时从外部内存中检索信息,从而有效地扩展了上下文。跨批次训练过程使模型倾向于学习易于内存注意力层使用的(key, value)表示。

(3). 内存注意力层L在推理过程中可以访问外部内存数据库。每个查询ℓ ∈ L会关注来自本地上下文的前面的键以及内存中与之最匹配的前k个键。内存键通过与查询的内积进行排名,并使用kNN搜索算法检索。我们使用FAISS中实现的精确kNN搜索算法。

(4). 我们的训练过程是一种新颖的训练(transformer-based)架构的方法,旨在改善(key, value)空间的结构。主要思想是通过对比学习的启发,让注意力层ℓ暴露于给定文档的当前和前一个本地上下文的(key, value)对(正样本)以及来自不相关文档的d-1个上下文的(key, value)对(负样本)。这一过程是可微分的。

(5). 为了实现这一点,我们使用了一个数据管道,其中批次的每个元素对应于不同的文档。我们嵌入了每个处理文档的前一个(C prev)和当前(C curr)本地上下文。具体来说,对于C curr中的每个文档δ,我们创建一个集合{p δ i} i={1,...,d},其中包含来自δ的前一个本地上下文的(key, value)对(正样本),以及来自C prev的d-1个其他上下文的(key, value)对(负样本)。我们还尝试对不同批次元素使用不同数量的前一个上下文和负样本。

(6). 训练过程中不使用外部内存。这有两个重要的后果。一方面,该操作是完全可微的,因此我们改进了所有p δ中的(key, value)对。另一方面,该过程易于实现;它不需要任何额外的损失(即使用标准的transformer训练目标)并且在数据加载管道和微小的自注意力变化的级别上完成。唯一的新超参数是d,它规定了正样本与负样本的比例。通常,我们发现从小的d ≤ 8开始(否则,模型倾向于忽略前一个本地上下文),然后切换到较大的值,如d ≥ 64。

实验设置:

- 实验设置(Experimental setting): (1). 本文提出了一种名为Focused Transformer (FOT)的技术,通过对比学习的训练过程来增强(key, value)空间的结构,从而扩展上下文长度。 (2). 作者使用了3B和7B OpenLLaMA检查点进行了Fine-tuning,得到了名为LONGLLAMA 2的模型,这些模型在需要长上下文的任务中展现出了进展。 (3). 作者在TREC问题分类和WebQS问题回答两个下游任务上评估了LONGLLAMA模型的长上下文能力,并与标准Fine-tuning进行了比较。 (4). 作者还通过使用LM Evaluation Harness库对LONGLLAMA模型进行了评估,结果表明性能保持完好,可以作为LLaMA模型的替代品使用。

实验结果:

实验结果和分析: (1) 在长上下文任务中,使用Focused Transformer (FOT)技术进行fine-tuning的LONGLLAMA模型在TREC问题分类和WebQS问题回答任务上表现出显著的准确率提升。在TREC任务中,使用FOT技术的模型在扩展上下文中取得了显著的准确率提升,而标准fine-tuning的基准模型在扩展上下文中没有提供任何改进。在WebQS任务中,使用FOT技术的模型在扩展上下文中也获得了一些改进。这表明FOT技术具有超出训练长度的外推能力。

(2) LONGLLAMA模型在长上下文任务中的性能保持完好,与原始LLaMA模型相比,性能没有明显下降。这表明LONGLLAMA模型可以作为LLaMA模型的替代品,并且与原始LLaMA推理代码兼容。

(3) 在passkey检索任务中,使用FOT技术fine-tuning的3B模型在长度为100k和256k的提示下取得了94.5%和73%的准确率,远远超过了其训练上下文长度8K。这表明FOT技术可以扩展模型的有效上下文长度。

(4) 在其他少样本学习任务中,使用FOT技术进行fine-tuning的模型在扩展上下文中提供了更多的准确率改进。在大多数任务中,提供更多的少样本示例可以在扩展上下文中提供更好的性能。

(5) FOT技术的训练过程受到对比学习的启发,通过增强(key, value)空间的结构,使模型能够扩展上下文长度。这种方法可以对现有的大规模模型进行微调,从而延长其有效上下文。

(6) LONGLLAMA模型的检查点和源代码已经发布,可以在相关资源中获取。

(7) LONGLLAMA模型在LM Evaluation Harness库上的性能保持完好,可以作为LLaMA模型的替代品使用。

(8) FOT技术的外推能力是基准模型所不具备的,这在实验结果中得到了验证。

(9) FOT技术的应用使得模型能够处理更长的上下文,提高了在长上下文任务中的性能。

(10) 通过对比FOT技术和标准长上下文fine-tuning的模型,实验结果表明FOT技术在fine-tuning所使用的上下文长度上已经取得了更好的性能,并且可以在超出该上下文长度的情况下进行外推,而基准模型无法实现这一点。

P:2 07-06 具有超出分布泛化能力的大型视觉-语言模型蒸馏

- Title: Distilling Large Vision-Language Model with Out-of-Distribution Generalizability

- 论文简介: 本文由UC San Diego的作者提出了一种通过模型蒸馏的方法,将大型视觉-语言模型中的视觉表示蒸馏到轻量级学生模型中,解决了开放词汇的超出分布(OOD)泛化问题。

- Authors: Xuanlin Li, Yunhao Fang, Minghua Liu, Zhan Ling, Zhuowen Tu, Hao Su

- Affiliation: UC San Diego(加州大学圣地亚哥分校)

- Keywords: vision-language models, model distillation, out-of-distribution generalization, open-vocabulary classification

- Paper: Link Github: None

- 论文总结:

- (1): 本文研究了大型视觉-语言模型的蒸馏问题,特别关注了开放词汇的超出分布(OOD)泛化问题。

- (2): 过去的方法很少关注模型蒸馏中的OOD泛化问题,本文提出了两个原则来增强学生模型的OOD泛化能力:通过更好地模仿教师的视觉表示空间和提高视觉-语言对齐的一致性;通过丰富教师的语言表示来有效区分不同标签。

- (3): 本文提出了几个度量标准,并进行了大量实验来研究它们的技术。实验结果表明,所提出的方法在开放词汇的OOD分类任务中显著提高了学生模型的性能。

- (4): 本文在开放词汇的OOD分类任务上取得了显著的零样本和少样本学生模型性能提升,突出了所提出方法的有效性。

方法部分:

方法详细介绍:

a. 一句话概览:本文提出了一种将大型视觉-语言模型中的视觉表示蒸馏到轻量级学生模型的方法,重点关注开放词汇的分布外泛化问题。

b. 方法的详细步骤: (1). 问题设置:将大型视觉-语言教师模型T蒸馏为小型学生图像模型S,重点关注开放词汇的目标分类问题。教师模型由图像编码器T_img和文本编码器T_txt组成,学生模型S仅为视觉模型。通过这个过程,希望学生模型S在已见标签上具有高预测准确性的同时,也能在分布外标签上具有强大的泛化能力。为了避免标签污染,学生模型从头开始训练。

(2). 实验设置:给定训练数据集X_train、内部分布评估数据集X_id和分布外评估数据集X_ood。每个数据集都包含图像-标签对{(x, y)}。对于(X_train ∪ X_id)中的(x, y),y属于内部分布标签集Y_id;对于X_ood中的(x, y),y属于分布外标签集Y_ood。在X_id上评估学生模型的性能,并在X_ood上进行零样本和少样本泛化性能评估。对于少样本学习,对学生模型进行微调。采用平衡的训练批次,其中至多一半的样本来自少样本数据,其余来自X_train。这种策略可以保证微调前后在X_id上的性能相似。

(3). 显式增强教师-学生视觉-语言对齐一致性:通过引入L_vlprox损失函数,有效且谨慎地保持教师的视觉-语言对齐结构。L_vlprox结合了教师和学生的标签概率,过滤出与语言标签不对齐的图像,并选择每个图像的最相似的k个语言特征。实验结果表明,L_vlprox可以进一步提高学生模型在分布外概念上的泛化能力。

(4). 丰富语言表示:通过使用ChatGPT生成丰富的标签描述,以及使用OFA生成图像标题,来增强语言表示。ChatGPT生成详细的类别描述,OFA为每个图像生成标题。在学生训练过程中,除了使用之前的视觉-语言对齐损失函数,还采用了辅助损失函数L_cap,用于区分属于同一类别的标题。在学生推理和标签预测时,仍然使用之前的语言表示。

(5). 学习提示来修改语言表示:通过修改提示来改变教师的语言表示空间,并影响视觉-语言对齐。在学生训练过程中,采用CoOp方法进行提示学习,优化8个令牌作为提示。

以上是本文方法的详细步骤。

实验设置:

- 实验设置: 本文研究了使用小型或中型数据集将大型视觉语言模型中的视觉表示蒸馏到轻量级学生模型中的过程。研究重点关注了开放词汇的分布外泛化问题,这是以前的模型蒸馏文献中被忽视的一个具有挑战性的问题。为了增强学生模型的分布外泛化能力,从视觉和语言模态的角度提出了两个原则:(1)更好地模仿教师的视觉表示空间,并通过与教师的视觉-语言对齐促进更好的一致性;(2)通过丰富教师的语言表示与信息丰富的语义属性,有效区分不同的标签。作者提出了几个度量标准,并进行了大量实验来研究他们的技术。实验结果表明,在开放词汇的分布外分类中,学生模型的零样本和少样本性能显著提高,验证了所提方法的有效性。

实验结果:

实验结果和分析: 本文通过实验研究了将大型视觉语言模型中的视觉表示蒸馏到轻量级学生模型的方法,并关注了开放词汇的分布外泛化问题。研究提出了两个原则来增强学生模型的分布外泛化能力:(1)更好地模仿教师模型的视觉表示空间,并在视觉-语言对齐方面提高一致性;(2)通过丰富教师模型的语言表示,使用信息丰富的语义属性来有效区分不同的标签。实验结果表明,采用这些方法可以显著提高学生模型在开放词汇的分布外分类任务中的零样本和少样本性能。具体实验结果如下:

- 在学生模型的分布外泛化方面,将LLM(Large Language Model)丰富的标签描述与辅助字幕相结合可以取得最佳的效果。但是,单独依赖辅助字幕对零样本分布外泛化的提升效果较小。此外,辅助字幕生成的描述通常对细粒度类别的区分能力较弱。

- 学生训练过程中的提示信息会降低其零样本分布外泛化性能,但在少样本情况下,这些提示信息可以快速适应新概念,从而使学生模型在少样本分布外任务中表现最佳。

- 通过分析语言空间结构的变化,发现采用语言丰富策略后,语言空间中的特征更加独立和有意义,有助于区分不同的类别。此外,丰富的语义属性使得文本特征之间的余弦相似度更小,更容易区分不同的类别。

- 在视觉空间和视觉-语言对齐方面的设计方案中,增强与教师模型的视觉-语言对齐一致性以及学生模型整体视觉空间的模仿都有助于学生模型的分布外泛化能力。

- 在不同的学生网络架构下,实验结果一致,即增强视觉-语言对齐一致性、改善视觉-语言对齐的一致性以及丰富语言表示都可以提高学生模型的分布外泛化能力。

- 在少样本学习策略方面,与基于检索的策略相比,对学生模型的视觉网络进行微调可以取得更好的效果。这可能是因为学生模型在小规模数据集上训练,对于分布外概念的泛化能力较弱,不适合采用基于检索的方法。

- 在少样本学习后,学生模型的零样本分布外泛化能力略有提高,表明学生模型可以不断适应新概念。

综上所述,本文的实验结果表明,通过采用视觉-语言对齐一致性、语言表示丰富等方法,可以显著提高学生模型在开放词汇的分布外分类任务中的性能。

P:3 07-06 KORC: 面向深度文本理解的知识导向阅读理解基准测试

- Title: KORC: Knowledge oriented Reading Comprehension Benchmark for Deep Text Understanding

- 论文简介: 本文由清华大学的研究人员提出,通过利用大规模知识库来构建有知识的问题,解决了现有基准测试中知识覆盖有限和答案空间狭窄的问题。

- Authors: Zijun Yao, Yantao Liu, Xin Lv, Shulin Cao, Jifan Yu, Lei Hou, Juanzi Li

- Affiliation: 清华大学

- Keywords: deep text understanding, reading comprehension, knowledge bases, benchmark

- Paper: Link to Paper Github: Link to Github

- 论文总结:

- (1): 本文的研究背景是深度文本理解,需要将给定文档与超出其文本的先验知识进行连接。

- (2): 过去的方法大多需要人工注释知识,导致知识覆盖有限。此外,它们通常使用文本中的选择或片段作为答案,导致答案空间狭窄。本文的方法通过利用大规模知识库来构建有知识的问题,并使用知识库中的标签作为最终答案,解决了这些问题。

- (3): 本文提出了一种新的挑战性基准测试KORC,它具有广泛的知识覆盖和灵活的答案格式。通过利用大规模知识库来指导注释者或大型语言模型构建有知识的问题,并使用知识库中的标签作为最终答案。此外,本文还提出了两个新的评估指标来处理变量数量的答案。

- (4): 本文在KORC上测试了最先进的模型,实验结果表明,最强的基线模型在内部分布和外部分布测试集上的F1值分别为68.3%和30.0%。这些结果表明,深度文本理解仍然是一个未解决的挑战。本文的创新点在于构建了一个具有广泛知识覆盖和灵活答案格式的基准测试,为深度文本理解的研究提供了新的方向。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了一种名为KORC的新型挑战性基准,通过利用大规模知识库指导注释者或大型语言模型构建有知识的问题,并使用知识库中的标签作为最终答案,以克服现有基准的知识覆盖和答案空间狭窄的限制。

b. 方法的详细步骤: (1). 准备文档并通过实体链接和文档级关系抽取将其与背景知识库对齐。 (2). 准备将文档和背景知识库编织在一起的推理链。首先从背景知识库中挖掘大量的关系组合规则,然后相应地提取推理链。 (3). 通过对问题实体进行匿名化以防止推理捷径,并基于推理链生成问题,对数据进行注释。设计了三种不同的方法来注释数据:基于模板的生成、人工注释和大型语言模型注释。

具体步骤如下: 1. 准备文档和背景知识库: - 从维基百科中采样文档作为阅读材料。 - 使用Wikidata5M作为背景知识库,它是维基百科中所有实体的子集。 - 通过实体链接将维基百科中的文档与Wikidata中的实体ID对齐。 - 从文档中提取语义三元组,并将其编织到推理链中。

- 实体链接:

- 首先通过现有的超链接将提及链接到维基百科实体,或使用在Wikipedia-BLINK上预训练的实体链接工具包。

- 然后使用XLORE将维基百科实体链接到Wikidata实体。

- 构建推理链:

- 从背景知识库中挖掘大量的关系组合规则。

- 根据规则提取推理链,将文档和背景知识库编织在一起。

- 数据注释:

- 对问题实体进行匿名化,以防止推理捷径。

- 基于推理链生成问题。

- 使用三种不同的方法进行数据注释:基于模板的生成、人工注释和大型语言模型注释。

以上是本文提出的KORC方法的详细步骤。通过这种方法,可以克服现有基准的知识覆盖和答案空间狭窄的限制,提供更广泛的知识覆盖和促进知识推理。

实验设置:

- 实验设置(Experimental setting): 本文建立了一个名为KORC的新的基准测试集,用于评估深度文本理解的能力。与之前的基准测试集相比,KORC具有广泛的知识覆盖和灵活的答案格式。为了构建KORC,研究人员利用大规模的知识库指导注释者或大型语言模型构建有知识的问题,并使用知识库中的标签作为最终答案。实验中使用了四种不同的基线模型进行测试,包括经过微调的语言模型、In-Context Learning (ICL) Prompting、检索增强模型和文本与知识库的联合推理模型。实验结果表明,当前最强的基线模型在KORC上的性能仍然有限,表明深度文本理解仍然是一个未解决的挑战。

实验结果:

实验结果和分析: KORC是一个新的具有广泛知识覆盖和灵活答案格式的挑战性基准测试。在KORC上测试了最先进的模型,实验结果显示,最强的基准模型在内部测试集上的F1值为68.3%,在外部测试集上的F1值为30.0%。这些结果表明,深度文本理解仍然是一个未解决的挑战。

实验结果还发现,ICL提示的LLMs在OOD集上表现比ID集更好,这个反直觉的结果是由于重复问题导致的。ID集与训练集具有相似的分布,因此LLMs直接从示例中复制结果,而OOD集则迫使模型独立思考。

另外,EmbedKGQA *模型的性能明显低于EmbedKGQA,这是由于其受限于GPU的随机访问内存,无法容纳更多的背景知识。这进一步反映了KORC的广泛知识覆盖。

总体而言,KORC基准测试的实验结果表明,深度文本理解仍然是一个具有挑战性的问题,目前的模型仍有改进的空间。

P:4 07-06 大型语言模型评估综述

- Title: A Survey on Evaluation of Large Language Models

- 论文简介: 本文是一篇关于大型语言模型评估的综述,由多个高校和公司的作者合作完成,通过总结现有的评估方法和基准,旨在为研究人员提供有价值的洞见,促进更加高效的大型语言模型的发展。

- Authors: Yupeng Chang, Xu Wang, Jindong Wang, Yuan Wu, Kaijie Zhu, Hao Chen, Linyi Yang, Xiaoyuan Yi, Cunxiang Wang, Yidong Wang, Wei Ye, Yue Zhang, Yi Chang, Philip S. Yu, Qiang Yang, Xing Xie

- Affiliation: Yupeng Chang, Xu Wang, Yuan Wu, and Yi Chang are with Jilin University, China.

- Keywords: Large language models, evaluation, model assessment, benchmark

- Paper: Link to the paper Github: Link to the code

- 论文总结:

- (1): 本文研究了大型语言模型评估的背景和现状;

- (2): 文中总结了过去的评估方法和基准,并指出了它们存在的问题,提出了新的评估方法和基准;

- (3): 本文提出了一种综合评估大型语言模型的方法,并对其在不同任务上的性能进行了评估,为大型语言模型的发展提供了有价值的参考;

- (4): 本文在多个领域的任务上评估了大型语言模型的性能,取得了令人满意的结果,支持了其目标和创新贡献。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文综述了大型语言模型(LLMs)的评估方法,主要从评估任务、评估方法和评估基准三个维度进行了全面的总结和分析。

b. 方法的详细步骤: (1). 自动评估方法:自动评估通常使用各种指标和评估工具(如BLEU、ROUGE、BERTScore等)来量化模型生成文本与参考文本之间的相似性和质量。自动评估不需要人工参与,节省了评估成本和时间。本文介绍了一些先进的自动评估技术,如LLM-EVAL和可复现的自动语言模型评估方法。

(2). 人工评估方法:人工评估通过人工参与来评估模型生成结果的质量和准确性。与自动评估相比,人工评估更接近实际应用场景,可以提供更全面和准确的反馈。本文列举了一些使用人工评估方法进行评估的案例,如专家评估、研究人员评估和普通用户评估。同时指出人工评估也存在一定的差异和不稳定性,可能受到文化和个体差异的影响。

(3). 结合实际情况的评估方法:在实际应用中,综合考虑自动评估和人工评估的结果,根据实际情况进行权衡和选择。本文介绍了一些结合实际情况的评估方法,如Human-in-the-loop AdaVision、AdaTest、Crowd-sourcing testing等。同时还介绍了一些更具挑战性的评估测试,如DeepTest、CheckList、AdaFilter等。

(4). 未来挑战:最后,本文指出了LLMs评估面临的一些未来挑战,如评估标准的制定、评估方法的改进和评估结果的可解释性等。这些挑战需要研究者们共同努力,以促进更加高效和可靠的LLMs评估方法的发展。

(5). 总结:本文综述了LLMs的评估方法,从评估任务、评估方法和评估基准三个维度进行了全面的总结和分析。通过介绍自动评估和人工评估方法,以及结合实际情况的评估方法,为研究者们提供了宝贵的参考和启示,促进了更加高效和可靠的LLMs评估方法的发展。

实验设置:

- 实验设置(Experimental setting): 本文主要对大型语言模型(LLMs)的评估方法进行了综述,重点关注了评估任务、评估方法和评估基准三个方面。首先,从评估任务的角度提供了概述,包括通用自然语言处理任务、推理、医疗应用、伦理、教育、自然科学、社会科学、代理应用和其他领域。其次,介绍了评估方法和基准,包括K折交叉验证、留出验证、留一交叉验证、自助法和减少集合等。然后,总结了LLMs在不同任务中的成功和失败案例。最后,指出了LLMs评估面临的几个未来挑战。本文的目的是为LLMs评估领域的研究人员提供宝贵的见解,促进更高效的LLMs发展。

(1). 评估任务:本文从通用自然语言处理任务、推理、医疗应用、伦理、教育、自然科学、社会科学、代理应用和其他领域等多个角度对LLMs进行评估。

(2). 评估方法和基准:介绍了K折交叉验证、留出验证、留一交叉验证、自助法和减少集合等评估方法和GLUE、SuperGLUE等作为评估基准。

(3). 成功和失败案例:总结了LLMs在不同任务中的成功和失败案例。

(4). 未来挑战:指出了LLMs评估面临的几个未来挑战。

实验结果:

实验结果和分析: 本文对大型语言模型(LLMs)的评估方法进行了综合回顾,主要关注三个关键维度:评估内容、评估位置和评估方法。首先,从评估任务的角度提供了一个概述,包括一般自然语言处理任务、推理、医疗应用、伦理、教育、自然和社会科学、代理应用和其他领域。其次,通过深入研究评估方法和基准,回答了“在哪里”和“如何”进行评估的问题。然后,总结了LLMs在不同任务中的成功和失败案例。最后,对LLMs评估面临的几个未来挑战进行了展望。

具体实验结果如下: 1. AI模型评估是评估模型性能的关键步骤。本文介绍了一些标准的模型评估协议,包括K折交叉验证、留出验证、留一法交叉验证(LOOCV)、自助法和减少集合。适当的评估方法应根据具体问题和数据特征选择,以获得更可靠的性能指标。

- LLMs的评估通常使用GLUE或SuperGLUE作为常见的测试集。这些测试集可以评估LLMs在不同任务中的性能。

- HELM是一个综合评估LLMs的评估框架,它评估语言模型在语言理解、生成、连贯性、上下文敏感性、常识推理和领域特定知识等各个方面的表现。

- KoLA是一个专门设计用于评估LLMs的知识导向评估基准,重点评估LLMs的语言理解和推理能力。

- DynaBench是一个用于进行动态基准测试的评估框架,它探索了在交互环境中集成循环、分布变化特征、评估者效率、专家评估者的影响以及增强模型对有针对性的对抗攻击的鲁棒性等新的研究方向。

- AlpacaEval是一个自动化评估基准,重点评估LLMs在各种自然语言处理任务中的性能。它提供了一系列指标、鲁棒性度量和多样性评估,以评估LLMs的能力。

- AGIEval是专门设计用于评估基础模型在人类中心化标准化考试环境中的性能的评估基准。

- Leaderboard是一个评估基准,提供了一个公开的竞赛平台,用于比较和评估不同LLMs模型在各种任务上的性能。

- GLUE-X是一个旨在评估NLP模型在OOD场景中的鲁棒性的统一基准。它强调了NLP鲁棒性的重要性,并提供了衡量和提高模型鲁棒性的见解。

- PandaLM是一个用于区分高水平LLMs的大规模语言模型的自动评估基准。它考虑了相对简洁性、清晰度、遵循指令、全面性和形式性等重要主观因素。

- MultiMedQA是一个医疗问答基准,重点评估LLMs在临床知识和QA能力方面的表现。

- SOCKET是一个专门设计用于评估LLMs在学习和识别社交知识概念方面的NLP基准。

- API-Bank是专门为工具增强的LLMs设计的第一个基准。它包括一个综合的工具增强LLM工作流,涵盖了53个常用的API工具和264个带有568个API调用的注释对话。

- ToolBench项目旨在通过提供创建优化指令数据集的平台,推动语言模型的进展和增强其实际应用。

综上所述,本文综合回顾了LLMs的评估方法,并介绍了多个评估基准和框架,以评估LLMs在不同任务和领域中的性能。这些评估方法和基准有助于研究人员更好地评估和发展更高效的LLMs。

P:5 07-06 PROTO-CLIP: 视觉-语言原型网络用于少样本学习

- Title: PROTO-CLIP: Vision-Language Prototypical Network for Few-Shot Learning

- 论文简介: 该论文由The University of Texas at Dallas提出了一种新颖的少样本学习框架,利用大规模的视觉-语言模型(如CLIP)来解决少样本学习问题。

- Authors: Jishnu Jaykumar, Kamalesh Palanisamy, Yu-Wei Chao, Xinya Du, Yu Xiang

- Affiliation: The University of Texas at Dallas (达拉斯大学)

- Keywords: Robot Perception, Object Recognition, Few-Shot Learning, Contrastive-Learning, Vision-Language, Multimodal

- Paper: Paper Github: None

- 论文总结:

- (1):该论文的研究背景是构建能够在人类环境中自主执行任务的自主机器人,需要从感知数据中识别对象以理解所需的任务。

- (2):过去的方法包括基于对象模型和基于对象类别的方法,但它们都存在一些限制,如获取大量3D模型或大量图像的困难。

- (3):该论文提出了PROTO-CLIP,它在传统的单模态原型网络的基础上,利用图像原型和文本原型进行少样本学习。通过使用少样本示例,PROTO-CLIP联合调整CLIP中的图像编码器和文本编码器,并利用这两个编码器计算图像类别的原型进行分类。在适应过程中,该方法提出了对应类别的图像原型和文本原型的对齐,以增强两种原型的贡献。

- (4):该方法在少样本学习的基准数据集上进行了实验证明其有效性,并在机器人感知任务中进行了实际应用。

方法部分:

方法详细介绍:

a. 一句话概览:本文提出了一种基于大规模视觉-语言模型的新颖框架,名为PROTO-CLIP,用于少样本学习。该方法利用图像原型和文本原型进行少样本学习,并通过对齐相应类别的图像原型和文本原型来增强分类性能。

b. 方法的详细步骤: (1). 首先,考虑N-way K-shot分类问题,其中K ≪ N。将带有类别标签的图像集合作为支持集,用于计算图像类别的原型。 (2). 在PROTO-CLIP模型中,利用CLIP模型中的图像编码器和文本编码器来估计类别标签的条件概率。 (3). 通过使用原型网络来建模基于支持集的概率分布,计算图像原型和文本原型之间的距离。 (4). 引入损失函数来优化模型,包括负对数概率损失和原型对齐损失。 (5). 在实验中,使用多个基准数据集进行评估,并选择最佳的超参数配置。

以上是本文提出的PROTO-CLIP方法的详细步骤。该方法通过对齐图像原型和文本原型,利用大规模视觉-语言模型进行少样本学习,取得了良好的分类性能。

实验设置:

- 实验设置(Experimental setting):

- 数据集和评估指标(Datasets and Evaluation Metric):

- 使用了多个数据集进行评估,包括ImageNet、StandfordCars、UCF101、Caltech101、Flowers102、SUN397、DTD、EuroSAT、FGVCAircraft、OxfordPets和Food101。

- 在N-way K-shot分类设置中,每个类别从每个数据集中随机选择K张图像进行训练。

- 每个数据集都有一个验证集用于超参数调优,测试集用于评估,以分类准确率作为评估指标。

- 超参数选择(Choosing the Hyper-parameters: α and β):

- 通过实验发现,超参数α和β在分类准确率中起到关键作用。

- 对于每个数据集,使用验证集进行网格搜索来选择这两个参数的最佳值,并在实验中固定它们的值。

- PROTO-CLIP变体(PROTO-CLIP Variants):

- 提出了三种PROTO-CLIP的变体,分别是"PROTO-CLIP"、"PROTO-CLIP-F"和"PROTO-CLIP-F-QT"。

- "PROTO-CLIP"直接使用预训练的CLIP特征进行推理,不训练图像记忆和文本记忆,也不使用适配器。

- "PROTO-CLIP-F"在训练时使用适配器来训练图像记忆和/或文本记忆,可以更快地训练。

- "PROTO-CLIP-F-QT"在训练时对每个查询图像应用随机数据增强操作,并计算变换后的查询图像的CLIP图像特征。

- 适配器类型和可学习的文本记忆(Adapter Types and Learnable Text Memory):

- 不同数据集的特性不同,适配器类型和是否学习文本记忆会影响性能。

- 通过对适配器类型和可学习的文本记忆进行实验,选择每个数据集的最佳配置。

- 损失函数(Loss functions):

- 引入了三种不同的损失函数,分别是L1、L2和L3。

- L1损失函数对于推动查询图像的分类是必要的。

- L2和L3损失函数用于原型对齐,对于少样本分类有贡献。

- 主干网络(Backbones):

- 使用不同的主干网络进行实验,包括CLIP视觉变换器主干网络和CLIP ResNet主干网络。

- 总体上,更好的主干网络可以学习更强大的特征表示,从而提高分类准确率。

实验结果:

实验结果和分析: 本文提出了一种新颖的少样本学习框架PROTO-CLIP,通过利用大规模的视觉-语言模型CLIP进行学习。实验结果表明,PROTO-CLIP在各个基准数据集上取得了良好的性能。在ImageNet、StandfordCars、UCF101、Caltech101、Flowers102、SUN397、DTD、EuroSAT、FGVCAircraft、OxfordPets和Food101等数据集上进行了实验,并使用测试集的分类准确率作为评估指标。实验结果表明,PROTO-CLIP在这些数据集上取得了较高的分类准确率。

在实验中,作者发现两个超参数α和β在分类准确率中起到了关键作用。通过对验证集进行网格搜索,确定了这两个参数的最佳值,并在后续实验中使用这些值。

作者还进行了PROTO-CLIP的变体实验。其中,"PROTO-CLIP"是直接使用预训练的CLIP特征进行推理,而不训练图像记忆和文本记忆以及不使用任何适配器。"PROTO-CLIP-F"是在训练过程中使用适配器来训练图像记忆和/或文本记忆。"PROTO-CLIP-F-QT"是在训练过程中对每个查询图像应用随机数据增强操作,并计算变换后的查询图像的CLIP图像特征。实验结果表明,这些变体方法在不同数据集上的性能有所差异。

作者还进行了适配器类型和可学习文本记忆的实验。实验结果表明,在不同数据集上选择适配器类型和是否学习文本记忆对性能有影响。通过选择最佳配置,可以获得更好的性能。

作者还分析了不同损失函数的效果。实验结果表明,L1损失函数对分类准确率至关重要。同时,L2和L3损失函数对原型对齐也有贡献,验证了将图像和文本原型对齐用于少样本分类的动机。

最后,作者还比较了不同的主干网络对FewSOL数据集的影响。实验结果表明,更好的主干网络可以学习更强大的特征表示,从而提高分类准确率。CLIP视觉变换器主干网络的性能优于CLIP ResNet主干网络。

综上所述,实验结果表明PROTO-CLIP在少样本学习任务中取得了良好的性能,并且在不同数据集和配置下具有一定的灵活性。

P:6 07-06 临床领域LLaMA的参数高效微调

- Title: Parameter-Efficient Fine-Tuning of LLaMA for the Clinical Domain

- 论文简介: 本研究由爱丁堡大学的研究人员提出,采用参数高效的微调技术,针对临床领域进行了LLaMA模型的领域自适应,解决了临床应用中的计算需求大的问题。

- Authors: Aryo Pradipta Gema, Luke Daines, Pasquale Minervini, Beatrice Alex

- Affiliation: 爱丁堡大学

- Keywords: parameter-efficient fine-tuning, LLaMA, clinical domain, clinical notes, downstream tasks

- Paper: Paper Github: None

- 论文总结:

- (1): 本文研究背景是在临床应用中,传统的将预训练语言模型应用于新领域通常需要重新训练所有参数,但由于大型语言模型的计算需求巨大,这种方法变得不切实际。

- (2): 过去的方法通常是对整个模型参数进行微调,但由于大型语言模型的快速增长,这种方法需要大量的计算资源,这加剧了资源丰富和资源有限的研究机构之间的差距。本文的方法通过参数高效的微调技术,只微调了一小部分额外的参数,从而显著减少了领域自适应的计算需求。

- (3): 本文提出了Clinical LLaMA-LoRA,这是一个基于开源LLaMA模型构建的PEFT适配器层,通过使用从MIMIC-IV数据库获取的临床记录进行训练,从而创建了一个专门针对临床领域的适配器。此外,本文还提出了一个两步PEFT框架,将Clinical LLaMA-LoRA与Downstream LLaMA-LoRA进行融合,后者是专门针对下游任务的PEFT适配器。通过在多个临床预测数据集上评估该框架,并与临床训练的语言模型进行比较,我们的框架在所有临床下游任务的AUROC得分上取得了最先进的表现。在大规模多标签分类任务(如诊断和手术分类)中,我们观察到6-9%的AUROC得分显著提高。

- (4): 本文的方法在临床领域中实现了最先进的性能,通过参数高效的微调技术,显著减少了计算需求,并在多个临床下游任务中取得了优异的AUROC得分。这些结果支持了本文的目标,并在领域自适应和下游临床任务方面具有创新和贡献。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本研究提出了一种参数高效的Fine-Tuning方法,通过选择性地微调一小部分额外的参数,显著减少了领域适应的计算需求,并在临床领域的多个任务上取得了最先进的性能。

b. 方法的详细步骤: (1). 构建Clinical LLaMA-LoRA:在开源的LLaMA模型的基础上,构建了Clinical LLaMA-LoRA,这是一个适用于临床领域的PEFT适配器层。使用从MIMIC-IV数据库获取的临床笔记对Clinical LLaMA-LoRA进行训练,从而创建了一个专门为临床领域设计的适配器。

(2). 提出两步PEFT框架:将Clinical LLaMA-LoRA与Downstream LLaMA-LoRA相结合,形成一个两步PEFT框架。Downstream LLaMA-LoRA是另一个专门用于下游任务的PEFT适配器。该框架在多个临床预测任务的数据集上进行评估,并与经过临床训练的语言模型进行比较。

(3). 下游微调过程:在下游微调过程中,使用固定的模型超参数,以确保与可用的计算资源兼容。使用高斯过程回归进行贝叶斯优化,最多进行20次试验来优化每种PEFT方法的超参数。评估模型在下游任务上的性能时,报告接收者操作特征曲线下面积(AU-ROC)得分。

(4). 对比实验:与其他经过临床训练的语言模型进行对比实验,包括Bio+ClinicalBERT、BlueBERT、CORe和UmlsBERT。这些基线模型已经在临床数据上进行了训练,用于评估所提出的Clinical LLaMA-LoRA在下游临床自然语言处理任务中的性能。

(5). 结果评估:通过对多个临床预测任务的评估,计算平均AU-ROC得分,并与其他基线模型进行比较。在大规模多标签分类任务中,如诊断和手术分类,观察到6-9%的AU-ROC得分显著提升。

(6). 结论:所提出的方法在临床领域的Fine-Tuning中具有较高的参数效率,能够显著减少计算需求,并在多个临床预测任务上取得了最先进的性能。

实验设置:

- 实验设置(Experimental setting): 本研究提出了一种参数高效的微调方法(Parameter-Efficient Fine-Tuning, PEFT),用于将预训练的语言模型适应到临床领域。为了实现领域自适应,研究中使用了开源的LLaMA模型,并构建了一个专门针对临床领域的PEFT适配器层,命名为Clinical LLaMA-LoRA。该适配器层使用从MIMIC-IV数据库中获取的临床笔记进行训练。此外,研究还提出了一个两步的PEFT框架,将Clinical LLaMA-LoRA与另一个专门用于下游任务的PEFT适配器Downstream LLaMA-LoRA进行融合。在多个临床预测任务的数据集上评估了该框架,并与临床训练的语言模型进行了比较。实验结果表明,该框架在所有临床下游任务的平均AUROC得分上取得了最先进的表现,特别是在诊断和手术分类等大规模多标签分类任务中,AUROC得分提高了6-9%。

(1). 预训练实验设置: 在预训练阶段,采用了PEFT技术进行领域自适应预训练。所有PEFT技术仅训练了一小部分参数,仅占原始模型参数的0.001%至0.24%,大大减少了计算资源的需求和训练时间。预训练的最佳表现是使用LoRA技术进行的,其在临床领域自适应预训练中取得了最低的困惑度分数,分别为2.244和2.404。预训练得到的LoRA模型被称为Clinical LLaMA-LoRA,后续的下游微调实验将使用该模型。

(2). 下游微调实验设置: 在下游微调实验中,比较了基线模型、LLaMA和PMC-LLaMA模型的AUROC得分。其中,基线模型BlueBERT的宏平均AUROC得分最高,为69.59%。相比之下,LLaMA和PMC-LLaMA的宏平均AUROC得分分别为58.61%和60.51%,表现较差。这表明了临床特定微调的重要性。

实验结果:

实验结果和分析: 本研究使用Parameter-Efficient Fine-Tuning (PEFT)技术在临床领域进行了预训练和下游微调实验。预训练结果表明,PEFT技术仅训练了原始模型参数的0.001%至0.24%,大大减少了计算资源的需求和训练时间。其中,LoRA是最佳的PEFT技术,对LLaMA和PMC-LLaMA模型在临床领域的预训练中取得了最低的困惑度分数,分别为2.244和2.404。在下游微调实验中,使用预训练的Clinical LLaMA-LoRA模型进行微调,取得了优于基线模型的结果。与BlueBERT模型相比,LLaMA和PMC-LLaMA模型的宏平均AUROC分数分别为58.61%和60.51%,低于BlueBERT的69.59%。这表明临床特定的微调对于模型性能的提升非常重要。

P:7 07-06 通过数据重要性学习改进检索增强的大型语言模型

- Title: Improving Retrieval-Augmented Large Language Models via Data Importance Learning

- 论文简介: 本文由ETH Zürich的Xiaozhong Lyu等人提出了一种基于数据重要性学习的算法,通过对检索到的数据点进行数据重要性评估,改进了检索增强的大型语言模型。

- Authors: Xiaozhong Lyu, Stefan Grafberger, Samantha Biegel, Shaopeng Wei, Meng Cao, Sebastian Schelter, Ce Zhang

- Affiliation: ETH Zürich (苏黎世联邦理工学院)

- Keywords: retrieval augmentation, large language models, data importance learning, multilinear extension, utility function

- Paper: Link Github: [None]

- 论文总结:

- (1): 本文研究了检索增强的大型语言模型,解决了模型性能受检索数据质量限制的问题。

- (2): 过去的方法存在两个问题:对于尾部实体的处理能力较差,训练和微调成本高昂。本文的方法通过学习检索源的数据重要性,改进了检索增强模型的性能,并且不需要进一步的训练。

- (3): 本文提出了一种基于多线性扩展的算法,用于计算检索语料库中数据点的数据重要性。该算法具有多项式时间复杂度,并且可以精确计算权重,同时还提出了一种更高效的近似算法。

- (4): 本文在问答和数据填充任务中实验证明,通过修剪或重新加权检索语料库,可以提高大型语言模型的性能,甚至使小型模型在某些任务上超过GPT-3.5。此外,基于多线性扩展的权重计算方法在实践中计算速度非常快,即使对于包含1亿个数据点的语料库也可以在十分钟内完成计算。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文提出了一种基于多线性扩展的算法,用于评估检索数据点的数据重要性,从而改善检索增强的大型语言模型的性能。

b. 方法的详细步骤: (1). 通过计算验证集Dval上的特定权重wi的梯度,可以找到多线性扩展的效用函数的最优权重。具体计算公式为∂Ũ ∂wi = S⊆Dret\di (U (S ∪ {di}) − U (S)) • P [S] = xval ∈Dval 1 |Dval | • S⊆Dret\di (Uxval (S ∪ {di}) − Uxval (S)) • P [S] G(xval, wi) = 1 |Dval | • xval ∈Dval G(xval, wi) (4)。

(2). 由于直接计算公式(4)中的梯度存在指数时间复杂度,因此提出了一种高效的权重计算方法。针对检索增强模型,通过局部性的特性,可以在多项式时间复杂度内计算出精确的梯度。具体方法包括: - 对于具有加性效用函数的模型,可以通过计算最接近验证元组xval的检索语料库中的前K个最近数据点和答案生成器的预测来计算精确梯度。 - 对于一般的效用函数,提出了一种(ϵ, δ)-近似算法来计算梯度。 - 对于具有加性效用函数的模型,提出了一个多项式时间复杂度的算法来计算多线性扩展的效用函数权重的精确梯度。

(3). 通过修剪或重新加权检索语料库,可以提高大型语言模型的性能,而无需进一步训练。实验结果表明,即使是一个小模型(如GPT-JT)通过与搜索引擎API的结合,也能胜过没有检索增强的GPT-3.5。此外,实验还表明,基于多线性扩展的权重可以在实践中高效计算(例如,对于包含1亿个元素的语料库,计算时间不到十分钟)。

(4). 如果允许进行ϵ-近似计算,可以显著加快梯度的计算速度。通过定义边界点db,可以将梯度的绝对值限定在K个最近邻数据点的概率之和内。对于排名较低的数据点,其在K个最近邻集合中的概率较小,因此可以将其梯度的ϵ-近似值设为0。对于排名较高的数据点,可以计算其梯度的ϵ-近似值。

综上所述,本文提出了一种基于多线性扩展的算法,用于评估检索数据点的数据重要性,并通过修剪或重新加权检索语料库来改善大型语言模型的性能。该方法在实践中具有高效的计算速度,并且可以应用于具有加性效用函数的模型。

实验设置:

- 实验设置(Experimental setting):

- 本文的实验主要针对问题回答和数据填充任务进行了一系列的实验。

- 在问题回答任务中,使用了WikiFact数据集,其中的问题是从维基百科页面中提取的,每个问题的答案都可以在维基百科中找到。共使用了70个关系作为不同的下游任务。

- 在数据填充任务中,使用了两个常见的基准数据集:restaurant和buy。restaurant数据集需要填充餐厅表中的城市列,buy数据集需要填充电子产品表中的制造商列。

- 对于每个问题回答或数据填充任务的实验运行,将数据集随机分成验证集和测试集,并重复64次,报告平均准确率。

- 在数据填充任务的零样本基准中,使用了[17]中建议的提示。

- 使用了具有60亿参数的语言模型GPT-JT进行实验,并通过检索增强来增强模型性能。与商业化的GPT-3.5模型进行了对比。

- 使用Microsoft Bing搜索引擎生成每个任务的检索语料库,并根据Bing提供的排名分数对检索到的数据点进行排序。

- 在对检索语料库进行重新加权或修剪的实验中,选择了K=10,并将初始权重设置为0.5。通过运行投影梯度下降算法来计算最优权重,并在测试集上通过随机采样来计算准确率的期望。

- 使用LOO误差作为基准来优化检索语料库,并在计算预测之前移除具有低LOO误差的数据源。

- 实验结果表明,使用多线性扩展权重进行修剪或重新加权可以提高模型的性能,而无需对底层模型进行微调。

- 在注入噪声的实验中,通过随机替换正确答案来模拟噪声,并通过学习的权重进行修剪或重新加权,可以恢复模型在噪声语料库上的性能。

实验结果:

- 实验结果和分析(Experimental results and analysis): 本文通过一系列的实验对问题回答和数据填充任务进行了评估。在第3.1节中,确认了检索增强可以提高大型语言模型的性能。第3.2节和第3.3节展示了多线性扩展权重如何帮助我们识别检索语料库中的噪声/错误数据,并且通过修剪或重新加权检索语料库来提高性能,而无需对底层模型进行微调。在第3.5节中,对算法的运行时间进行了检查,结果表明在实践中可以非常快速地计算出权重(例如,对于包含1亿个元素的语料库,不到十分钟)。实验结果表明,通过修剪或重新加权检索语料库,我们可以提高大型语言模型的性能,而无需进一步训练。对于某些任务,甚至可以使小型模型(例如GPT-JT)在使用搜索引擎API进行增强的情况下,胜过GPT-3.5(无检索增强)。此外,我们还展示了在实践中可以高效地计算基于多线性扩展的权重(例如,对于包含1亿个元素的语料库,不到十分钟)。

P:8 07-06 风格胜过实质:大型语言模型的评估偏见

- Title: Style Over Substance: Evaluation Biases for Large Language Models

- 论文简介: 本文由Mohamed bin Zayed University of Artificial Intelligence和Monash University的Minghao Wu和Alham Fikri Aji共同完成,通过研究大型语言模型(LLMs)的评估偏见,提出了一种多维度评估方法。

- Authors: Minghao Wu, Alham Fikri Aji

- Affiliation: Mohamed bin Zayed University of Artificial Intelligence (MBZUAI) (莫哈迪本扎耶德人工智能大学)

- Keywords: large language models, evaluation biases, human evaluations, LLM-based judges

- Paper: Paper Github: None

- 论文总结:

- (1): 本文研究背景是随着大型语言模型(LLMs)的发展,对其性能进行准确全面的评估变得越来越具有挑战性。

- (2): 过去的方法主要使用人工评估作为评估标准,最近的研究开始使用LLMs作为评估代理,但人类评估者和LLMs评估者的能力尚不确定。本文提出了一种多维度评估方法,以解决评估过程中的偏见问题。

- (3): 本文通过构建一个包含有意引入错误的机器生成答案的数据集,研究了众包人类评估者和LLM评估者在比较不同模型输出时的行为。提出了基于Elo评分系统的多维度评估方法,名为Multi-Elo评分系统。实证结果表明,该方法显著提高了LLM评估的质量,特别是在事实准确性方面。

- (4): 本文的研究任务是评估大型语言模型的性能,通过提出的多维度评估方法,取得了在事实准确性方面的显著改进。然而,在众包人类评估方面并未观察到明显的改进,需要进一步研究和改进。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本研究旨在调查众包人类评估者和基于大型语言模型(LLM)的评估者在比较不同模型生成的输出时的行为,并提出了一种多维度评估方法,即多Elo评分系统,以提高LLM评估的质量。

b. 方法的详细步骤: (1). 介绍Elo评分系统:Elo评分系统是一种用于计算两个玩家在两人游戏(如国际象棋)中相对技能水平的方法。根据两个玩家A和B的Elo评分RA和RB,计算预期得分EA和EB。根据实际得分SA和SB,使用调整参数K计算更新后的Elo评分RA'和RB'。为了减少游戏顺序的影响,根据建议,使用不同的随机顺序进行Elo评分计算。

(2). 生成错误答案:为了评估不同模型生成的答案,我们生成了有意制造错误的机器生成答案。错误类型包括语言质量错误和事实准确性错误。语言质量错误包括高级英语学习者和中级英语学习者的回答,可能包含拼写错误或语法错误。事实准确性错误包括次要错误和重大错误,涉及虚构的名称、错误的数字或错误的事实和建议。

(3). 人类评估和LLM评估:评估机器生成的文本包括自动评估和人工评估。自动评估使用定量指标将生成的文本与参考或黄金标准进行比较,衡量n-gram重叠、精确度、召回率和语义相似性等方面。然而,自动评估存在局限性,可能无法捕捉到所有细微差别和质量问题。因此,进行人工评估,人类评委根据流畅性、连贯性、相关性和整体实用性等标准评估文本。他们比较多个文本并选择最佳答案或按质量进行排名。最近的一些研究还将Elo评分系统应用于比较不同LLM的性能。

(4). 问题集筛选:根据特定要求,我们从Chiang等人的问题集中删除了一些类型的问题,如"fermi"、"coding"和"math"问题,以减少人类评估者能力的差异对评估过程的影响。此外,我们还删除了"roleplay"和"writing"问题,因为它们涉及创造性写作并容易受到主观评估的影响。最终,我们的问题集包含40个问题,重点关注"generic"、"knowledge"、"common sense"和"counterfactual"类别。

(5). Elo评分计算:根据生成的答案,我们使用Elo评分系统计算每个模型的Elo评分,以便进行有意义的比较。根据比赛结果,更新每个模型的Elo评分。

(6). 结果分析:通过实证结果,我们发现多Elo评分系统显著提高了LLM评估的质量,特别是在事实准确性方面。然而,对于人类评估,改进效果不明显,需要进一步研究和改进。

(7). 结论:本研究发现在评估过程中存在一种偏见,即具有事实错误的答案相对于过短或包含语法错误的答案更受青睐。为了解决这个问题,我们提出了多维度评估方法,即多Elo评分系统,以独立评估机器生成的文本。这种方法在提高LLM评估质量方面取得了显著效果,尤其是在事实准确性方面。然而,对于人类评估,改进效果不明显,需要进一步研究和改进。

实验设置:

- 实验设置(Experimental setting): 本研究考虑到大型语言模型(LLMs)的普及和对更广泛受众的可访问性,采用了众包人工注释方法,遵循Dettmers等人(2023)提出的方法。通过这种方法,我们能够收集来自不同个体的注释,并研究众包注释的行为。我们使用了Amazon Mechanical Turk (AMT)来收集人工评估的文本,这在自然语言生成的评估中是常用的方法。为了确保质量,我们限制参与者为来自英语国家的个体,包括美国、英国、加拿大和澳大利亚。

实验结果:

实验结果和分析: 本研究旨在调查众包人类评估者和基于大型语言模型(LLMs)的评估者在比较不同模型输出时的行为。为了实现这一目标,研究人员构建了一个包含有意制造的机器生成答案错误的数据集。研究结果表明,尽管事实错误可能带来更大的危险,但带有事实错误的答案仍然比过短或包含语法错误的答案评分更高。这揭示了评估过程中存在的一种令人担忧的偏见。为了解决这个问题,研究人员提出了独立评估机器生成文本的多个维度的方法,而不是将所有评估方面合并为一个分数。他们使用Elo评分系统实现了这个想法,提出了多Elo评分系统。实证结果表明,这种方法显著提高了基于LLMs的评估的质量,特别是在事实准确性方面。然而,在众包评估中并没有观察到显著的改进,这表明需要进一步的调查和改进。

(1). 本研究发现,尽管存在事实错误,但带有事实错误的答案仍然比过短或包含语法错误的答案评分更高。这表明在评估过程中存在一种偏见。

(2). 研究人员提出了独立评估机器生成文本的多个维度的方法,并使用Elo评分系统实现了这个想法。实证结果表明,这种方法显著提高了基于LLMs的评估的质量,特别是在事实准确性方面。

(3). 在众包评估中,并没有观察到显著的改进,这表明需要进一步的调查和改进。

P:10 07-06 大型语言模型赋能自主边缘人工智能实现连接智能

- Title: Large Language Models Empowered Autonomous Edge AI for Connected Intelligence

- 论文简介: 本文介绍了一个自主边缘人工智能系统,通过在网络边缘提供高质量、低延迟和保护隐私的人工智能服务,自动组织、适应和优化以满足用户的多样化需求。

- Authors: Yifei Shen, Jiawei Shao, Xinjie Zhang, Zehong Lin, Hao Pan, Dongsheng Li, Jun Zhang, Khaled B. Letaief

- Affiliation: Yifei Shen, Hao Pan, and Dongsheng Li隶属于微软亚洲研究院,上海,中国

- Keywords: Edge artificial intelligence, connected intelligence, large language models, federated learning

- Paper: Link Github: None

- 论文总结:

- (1):本文研究背景是边缘人工智能在实现连接智能方面的挑战。

- (2):过去的方法将边缘人工智能系统划分为几个组件,但无法无缝集成它们。本文提出了一个自主边缘人工智能系统,通过利用大型语言模型GPT,自动组织、适应和优化以满足用户的多样化需求。

- (3):本文提出了一个基于云-边缘-客户端层次结构的自主边缘人工智能系统,其中大型语言模型GPT位于云端,其他人工智能模型部署在设备和边缘服务器上。通过利用GPT在语言理解、规划和代码生成方面的强大能力,提出了一个多功能框架,通过边缘联邦学习自动生成代码来训练新模型,以满足用户的个性化需求。

- (4):本文的方法在实验中展示了系统准确理解用户需求、高效执行AI模型以及通过联邦学习创建高性能AI模型的能力。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文介绍了一种自主边缘人工智能系统,通过在云端部署大型语言模型(GPT)并在设备和边缘服务器上共同部署其他人工智能模型,实现自动组织、适应和优化以满足用户的多样化需求。

b. 方法的详细步骤: (1). 设计云-边缘-客户端层次结构:该系统采用云-边缘-客户端层次结构,其中大型语言模型GPT位于云端,其他人工智能模型则共同部署在设备和边缘服务器上。

(2). 利用GPT的能力:通过利用GPT在语言理解、规划和代码生成方面的强大能力,设计了一个多功能框架,可以高效协调边缘人工智能模型以满足用户的个人需求,并通过边缘联邦学习自动生成代码来训练新模型。

(3). 自主边缘人工智能的能力:该系统具备自主组织和自我改进的能力。自主组织能力包括准确理解用户的需求、高效执行人工智能模型以及整合模型结果以完成任务,从而解决传感器集成和用户界面设计的挑战。自我改进能力包括生成代码来优化现有人工智能模型和训练新模型,从而解决人工智能模型定制化的挑战。

(4). 应用领域:自主边缘人工智能系统在医疗监测、自动驾驶、工业物联网和智能设备等领域具有广泛的应用前景。

(5). GPT作为控制器:本文提出利用GPT作为控制器的可能性。GPT是一种强大的大型语言模型,具备开放领域问答、规划能力、上下文学习和代码生成等独特特点,能够协调边缘服务器上的现有模型并通过分布式学习创建新模型,实现自组织和自我改进的自主边缘人工智能系统。

(6). 云-边缘-客户端层次系统:该系统采用云-边缘-客户端层次结构,云服务器提供充足的计算资源支持GPT,客户端和物联网传感器具有有限的计算资源,边缘服务器则提供更大的计算资源。系统包括边缘人工智能模型协调和自动联邦学习两个部分。

(7). 边缘人工智能模型协调:GPT处理用户请求,将其分解为子任务,并将这些子任务分派给适当的边缘设备和人工智能模型。同时采用人工智能模型卸载和面向任务的通信技术,以实现低延迟的模型推理。

(8). 自动联邦学习:用户只需用自然语言描述其数据集,GPT负责生成所需的联邦学习代码,以训练具有满意性能的模型。

(9). GPT的能力:GPT具备回答开放领域问题、规划能力、上下文学习和代码生成等能力,能够理解用户意图、识别人工智能模型的特点并生成分布式学习代码来优化模型。

(10). 自主边缘人工智能的应用前景:自主边缘人工智能系统在医疗监测、自动驾驶、工业物联网和智能设备等领域具有广泛的应用前景。

(11). GPT作为控制器的优势:GPT作为控制器具备强大的语言理解、规划和代码生成能力,能够协调边缘服务器上的现有模型并通过分布式学习创建新模型,实现自组织和自我改进的自主边缘人工智能系统。

- 方法详细介绍(Method detailed introduction): 本文介绍了一种自主边缘人工智能系统,该系统能够自动组织、适应和优化自身以满足用户的多样化需求。该系统采用云-边缘-客户端的层次结构,其中大型语言模型(Generative Pretrained Transformer,GPT)位于云端,其他人工智能模型则共同部署在设备和边缘服务器上。通过利用GPT在语言理解、规划和代码生成方面的强大能力,提出了一个多功能框架,可以高效地协调边缘人工智能模型以满足用户的个人需求,并通过边缘联邦学习自动生成代码来训练新模型。实验结果表明,该系统能够准确理解用户需求,以最小的成本高效执行人工智能模型,并通过联邦学习有效地创建高性能的人工智能模型。

- 实验设置(Experimental setting): 本文设计了一个云-边缘-客户端的层次系统,其中GPT位于云端,其他人工智能模型共同部署在设备和边缘服务器上。用户的请求以自然语言的形式表达,首先由GPT进行处理,将其翻译和分解为边缘设备可以解决的子任务。然后,采用任务卸载算法和面向任务的通信,以最小化延迟。此方法实现了边缘人工智能模型之间的自主、智能和低延迟协调。此外,利用GPT设计适当的人工智能模型配置,并生成用于联邦学习的代码,从而为用户提供新的高精度模型,并保护其隐私。

- 实验结果和分析(Experimental results and analysis): 实验结果表明,该系统能够准确理解用户需求,并以最小的成本高效执行人工智能模型。通过联邦学习,系统能够有效地创建高性能的人工智能模型,并将其提供给用户。此外,该系统还能够保护用户的隐私。通过使用GPT作为智能控制器,系统能够自动组织现有的人工智能模型,并生成代码来训练新模型,无需人工干预。这使得边缘人工智能系统能够实现自主性,满足用户的多样化需求,并提供高质量的人工智能服务。

- 第一部分总结: 本文介绍了一种自主边缘人工智能系统,该系统利用大型语言模型(GPT)在云端和边缘设备上协调人工智能模型,以满足用户的个人需求。通过联邦学习,系统能够自动生成代码来训练新模型,并提供高性能的人工智能服务。实验结果表明,该系统能够准确理解用户需求,并以最小的成本高效执行人工智能模型,同时保护用户的隐私。

- 第二部分总结: 本文探讨了自主边缘人工智能的概念,并介绍了利用大型语言模型(GPT)作为自主边缘人工智能的潜力。自主边缘人工智能旨在解决现有边缘人工智能系统在实现连接智能方面面临的挑战。通过使用GPT作为智能控制器,系统能够自动组织现有的人工智能模型,并生成代码来训练新模型,无需人工干预。这使得边缘人工智能系统能够实现自主性,满足用户的多样化需求,并提供高质量的人工智能服务。

- 第三部分总结: 本文介绍了一种基于GPT的自主边缘人工智能系统,该系统采用云-边缘-客户端的层次结构,能够自动组织、适应和优化自身以满足用户的多样化需求。通过联邦学习,系统能够自动生成代码来训练新模型,并提供高性能的人工智能服务。实验结果表明,该系统能够准确理解用户需求,并以最小的成本高效执行人工智能模型,同时保护用户的隐私。这是第一篇探索GPT在边缘计算中潜力的论文,并提出了一个基于GPT的自主边缘人工智能框架。

P:11 07-06 你的配偶需要专业帮助:通过建模社交关系确定信息的上下文适宜性

- Title: Your spouse needs professional help: Determining the Contextual Appropriateness of Messages through Modeling Social Relationships

- 论文简介: 该论文由密歇根大学的David Jurgens、Agrima Seth、Jackson Sargent、以及加州大学戴维斯分校的Athena Aghighi和布法罗大学的Michael Geraci共同完成。他们通过建模社交关系来确定信息的上下文适宜性,并提出了一种新的研究方法。

- Authors: David Jurgens, Agrima Seth, Jackson Sargent, Athena Aghighi, Michael Geraci

- Affiliation: 密歇根大学

- Keywords: interpersonal communication, social context, appropriateness, relationship modeling

- Paper: Paper Github: None

- 论文总结:

- (1): 该论文的研究背景是理解人际交流需要理解信息所处的社交背景和规范。

- (2): 过去的方法在识别冒犯性内容时往往独立于上下文,很少考虑社区规范或先前对话作为上下文。本文提出了一种新的方法,通过显式建模个体之间的社交关系来确定信息的适宜性。

- (3): 本文提出了一种新的数据集,其中包含了关于信息在特定关系背景下是否适宜的标注。通过使用在线对话和电影对话的数据,研究人员展示了大型语言模型如何准确地识别给定上下文中的适宜性。此外,他们还证明了上下文适宜性判断对于识别语言中的其他社交因素(如居高临下和礼貌)具有预测能力。

- (4): 本文的方法在确定信息的上下文适宜性方面取得了良好的性能,最佳模型的二元F1达到了0.70。通过分析分类器的判断,研究人员揭示了关系之间共享规范的结构。此外,他们还发现大约19%的适宜信息在另一个上下文中可能被视为不适宜,这凸显了需要明确纳入关系的模型的必要性。最后,研究人员还展示了他们的模型在识别居高临下等微妙冒犯语言方面的有效性。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文介绍了一种通过建模社交关系来确定信息上下文适宜性的方法,通过构建一个新的数据集,展示了大型语言模型可以准确地在给定上下文中识别适宜性。

b. 方法的详细步骤: (1). 选择关系:通过从民间分类和组织社会角色中选择关系类型,构建了一个包含49种关系类型的初始关系列表。 (2). 定义适宜性:根据适宜性理论,将不同关系中的信息进行了操作化,判断信息是否在正常情况下适宜。 (3). 构建数据集:从Reddit中选择对话数据,并通过分类器筛选出具有对话性的评论。然后,通过两个阶段的注释过程,生成了包含401条信息和5,029个适宜性评分的数据集。 (4). 使用主动学习方法:通过训练一个基于T5模型的分类器,从大规模未标记的语料库中识别出可能与关系相关的信息,并进行注释。 (5). 数据评估:通过两个注释者对数据进行评估和讨论,最终得到了2,159个经过仲裁的适宜性评分和5,408个非仲裁的适宜性评分。

以上是本文方法的详细步骤,通过建模社交关系和构建新的数据集,实现了在给定上下文中准确识别信息适宜性的目标。

实验设置:

- 实验设置: 该论文介绍了一种新的方法来确定信息的上下文适宜性,通过显式建模社交关系来识别不适当的沟通。研究使用了TalkDown数据集中的Reddit评论和Stanford Politeness Corpus中的维基百科和StackExchange对话数据。作者采用了与相关论文相同的训练和测试集,并使用逻辑回归分类器预测信息的傲慢和不礼貌程度。实验结果表明,将关系作为上下文加入模型可以帮助识别微妙的冒犯信息,并且相比于之前的模型,仅使用上下文适宜性特征就能取得更好的效果。

(1). 数据集:使用了TalkDown数据集中的Reddit评论和Stanford Politeness Corpus中的维基百科和StackExchange对话数据。

(2). 模型:使用了flan-t5-xl模型来预测训练数据中每条信息的适宜性。采用逻辑回归分类器来预测信息的傲慢和不礼貌程度。

(3). 评估指标:采用了与相关论文相同的评估指标来评估模型的性能。

(4). 结果分析:通过对傲慢和不礼貌程度的预测结果进行分析,发现关系的适宜性得分与微妙的冒犯程度有着显著的相关性。

(5). 实验限制:该研究的上下文仅限于参与者之间的关系,而实际上社交上下文还包括许多其他因素。数据集中的关系类型有限,可能无法完全覆盖实际中的所有关系类型。评估适宜性的判断是基于少数几位标注者的价值观和生活经验,可能无法推广到其他社交或文化背景。

实验结果:

实验结果和分析: 本文通过建模社交关系来确定信息的上下文适宜性。研究表明,大型语言模型可以很好地将关系信息纳入到给定上下文中的适宜性判断中。通过在线对话和电影对话的数据,研究人员揭示了关系本身作为隐含规范的功能,并量化了不同对话环境中需要上下文敏感性的程度。此外,研究还表明,上下文适宜性判断可以预测语言中表达的其他社交因素,如居高临下和礼貌。

具体实验方面,研究使用了flan-t5-xl模型来预测TalkDown数据集中每条消息在讽刺性和礼貌性方面的适宜性。研究采用了与相关论文相同的训练和测试数据集,并使用逻辑回归分类器来预测每个数据集中的消息是否具有讽刺性或不礼貌性。实验结果表明,关系适宜性得分对于微妙的冒犯性具有显著的预测能力。此外,尽管分类器相对简单,但仅使用适宜性特征就能胜过Wang和Potts(2019)使用的bert-large分类器。

然而,本文的研究存在三个主要限制。首先,当前的上下文仅限于参与者之间的关系,而实际上社交上下文涵盖了许多其他因素,如参与者的社会人口统计学特征、对话的文化和环境以及参与者的历史。关系本身通常更加微妙,适宜性可能因环境而异,例如,夫妻之间的陈述在公共场合和私人场合可能具有不同的适宜性。因此,未来的研究可以探索如何通过直接输入情境的社交网络来将这些因素纳入考虑,例如使用图嵌入技术或对关系进行标记。其次,本文的数据集包含了有限的关系注释,实际上可能存在更多类型的关系。此外,新的在线空间等环境可能需要额外定义关系。第三,适宜性判断是基于五位注释者的价值观和生活经验进行的,可能无法推广到其他社交或文化背景中的关系规范。未来的研究需要通过额外的注释来探索这些规范的差异。

总体而言,本文的实验结果表明,建模社交关系可以帮助准确识别上下文中的不适宜性,并且关系适宜性得分对于微妙的冒犯性具有预测能力。然而,研究还存在一些限制,需要进一步研究和改进。

P:12 07-06 PRD:同行评审和讨论改进基于大型语言模型的评估

- Title: PRD: Peer Rank and Discussion Improve Large Language Model based Evaluations

- 论文简介: 本文由德克萨斯大学达拉斯分校的Ruosen Li、Teerth Patel和Xinya Du提出,通过引入同行评审和同行讨论的方法,改进了基于大型语言模型的评估问题。

- Authors: Ruosen Li, Teerth Patel, Xinya Du

- Affiliation: Ruosen Li: 德克萨斯大学达拉斯分校 Teerth Patel: 德克萨斯大学达拉斯分校 Xinya Du: 德克萨斯大学达拉斯分校

- Keywords: large language models, evaluation, peer rank, peer discussion

- Paper: Link to the paper Github: None

- 论文总结:

- (1): 本文的研究背景是现代大型语言模型的质量评估和比较问题。

- (2): 过去的方法主要使用最强的语言模型作为评估者,但存在自我增强和位置偏见等问题。本文提出了同行评审和同行讨论的方法来改进这些问题。

- (3): 本文提出了同行评审和同行讨论的框架,通过加权评分和多轮讨论来进行模型评估。这种方法在提高评估准确性和与人类判断的一致性方面取得了良好的效果。

- (4): 本文在两个基准数据集上进行了实验,结果表明所提出的方法在评估准确性和排名方面都取得了较好的表现。这些方法为解决难以比较的模型提供了一种新的评估方式,并具有创新性和贡献性。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了一种基于同行评审和同行讨论的方法,用于改进基于大型语言模型(LLM)的评估,通过引入同行评审算法和同行讨论算法,提高了模型的评估准确性和与人类判断的一致性。

b. 方法的详细步骤: (1). 同行评审算法(PR): - 对于给定的问题集合Q,为每个语言模型生成对应的答案。 - 使用语言模型和人工标注者进行答案之间的两两比较,生成一系列的对战评价。 - 根据这些对战评价,计算每个模型的胜率和Elo评分,从而对模型进行评估。 - 利用当前权重计算每个模型的得分,并将得分进行归一化和标准化,得到下一轮迭代的权重。 - 重复上述步骤,直到得到收敛的权重。

(2). 同行讨论算法(PD): - 选择两个语言模型进行讨论,尝试达成对两个答案的共识。 - 根据讨论的结果,更新模型的评估准确性和能力。

通过引入同行评审算法和同行讨论算法,本文提出的方法在大型语言模型的评估中取得了更高的准确性,并且与人类判断更加一致。这一方法为评估难以比较的模型提供了一种新的思路。

实验设置:

- 实验设置(Experimental setting): 本文选择了两个"元评估"数据集,用于人工注释的成对比较,以衡量评估方法与人类判断之间的相关性。其中,LFQA数据集包含了7个领域(如经济学、历史学和生物学)的140个长篇问题,每个问题有两个候选答案(来自GPT3或人类)。类似于ELI5数据集,LFQA包含了来自Reddit论坛“r/explainlikeimfive”和“r/AskHistorians”的更近期(即2021年7月之后)的问题。作者收集了专家级别的注释,确定了哪个答案更好(整体偏好)。由于人类偏好存在差异,作者报告了专家的(不)一致性,Fleiss' κ在0.5-0.6左右,准确率>0.8,表明有中度到大幅度的一致性。

Vicuna80数据集是由80个开放式问题组成,涵盖了各种类别,如角色扮演和写作。在QLoRA工作中,作者对每个问题的7个模型的答案进行了成对比较评分(整体偏好)。评分包括0、1、2,分别对应于平局、模型1获胜和模型2获胜。本文选择了4个模型答案的成对比较注释(即GPT4、Bard等),为了使研究更全面,还添加了最近的专有语言模型,如Claude 2。具体而言,还对Claude的答案与其他4个模型的答案进行了成对比较的注释。我们将这个更完整的数据集称为Vicuna80。关于注释过程的更多细节请参见附录E。由于开放式问题的答案更难比较,注释者达成了公平的一致。

在LFQA中,每个问题有1-3个专家级别的注释;在Vicuna80中,每个问题有3个人类注释。我们使用人类多数票作为人类偏好来进行比较。根据Wang等人的方法,首先进行示例级别的成对比较。具体而言,每个评估示例(成对比较)由一个问题和一对长篇答案组成。我们将模型预测的偏好分数与人类的偏好进行比较,并报告准确率和Fleiss' κ。根据Dettmers等人的方法,我们还将模型预测的全局排名分数与人类判断的排名分数进行比较。具体而言,我们报告基于Elo分数和胜率(WR)的排名(表2)。

对于PR的实验,我们使用"All"来表示每个评审员具有相等的权重;使用"All (weighted)"来表示最后一轮对每个评审员进行加权的设置。

对于Vicuna-13b,我们使用Chiang等人的默认版本。对于其他基于API的LLM模型,我们使用各自的特定版本。对于GPT-4、GPT-3.5、Claude和Bard,我们分别使用GPT-4-0613、GPT-3.5-turbo-0613、Claude-1和PaLM-2。更多细节请参见附录B。

除了分别在PR和PD上进行的实验(第3.3节和第3.4节),我们还在GPT-3.5和Vicuna-13b的答案质量判断实验中比较了PR和PD(表6)。

实验结果:

实验结果和分析: 本文通过对两个基准数据集进行实验,评估了提出的评估方法与人类判断之间的相关性。LFQA数据集包含了140个长篇问题,涵盖了经济学、历史学和生物学等七个领域,每个问题有两个候选答案(来自GPT3或人类)。Vicuna80数据集包含了80个开放性问题,作者对每个问题的7个模型的答案进行了两两比较的注释。实验结果表明,提出的方法在准确性和与人类判断的一致性方面表现更好。

在PR算法的实验中,作者使用了All和All (weighted)两种设置。实验结果显示,这两种设置都能够产生更高的准确性,并且在匿名设置下,PR算法能够相对准确地对模型进行自我排名。

在PD算法的实验中,作者对GPT-3.5和Vicuna-13b的答案质量进行了评估。实验结果表明,PD算法能够更好地判断两个答案的优劣。

除了PR和PD算法的实验,作者还对GPT-3.5和Vicuna-13b的答案质量进行了比较。实验结果显示,PD算法在判断这两个模型的答案质量时表现更好。

综上所述,实验结果表明,提出的PR和PD算法在评估大型语言模型的质量时能够取得更高的准确性,并且与人类判断更加一致。

P:13 07-05 无线多智能体生成人工智能:从连接智能到集体智能

- Title: Wireless Multi-Agent Generative AI: From Connected Intelligence to Collective Intelligence

- 论文简介: 本文介绍了将多智能体生成人工智能(AI)应用于无线网络的潜力和挑战,提出了一种基于多智能体生成AI的网络架构设计,并探讨了在竞争环境中协同解决任务的多智能体生成AI方法。

- Authors: Hang Zou, Qiyang Zhao, Lina Bariah, Mehdi Bennis, and M´erouane Debbah

- Affiliation: Hang Zou: 电子科技大学 Qiyang Zhao: 电子科技大学 Lina Bariah: 电子科技大学 Mehdi Bennis: 电子科技大学 M´erouane Debbah: 电子科技大学

- Keywords: wireless networks, generative artificial intelligence, multi-agent systems, large language models

- Paper: Link Github: None

- 论文总结:

- (1):本文研究了将多智能体生成AI应用于无线网络的背景和潜力。

- (2):过去的方法主要集中在云端的大型语言模型,存在计算和通信成本高的问题。本文提出了一种基于多智能体生成AI的网络架构,以解决这些问题。

- (3):本文提出了在竞争环境中协同解决任务的多智能体生成AI方法,并探讨了在网络层和智能体层面上的架构设计。

- (4):本文通过案例研究展示了无线多智能体生成AI网络的潜在应用和性能,证明了该方法在解决网络意图和实现无线集体智能方面的创新和贡献。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文介绍了在无线网络中部署生成式人工智能的方法,通过多个设备上的多个生成式语言模型实现集体智能,实现在边缘进行智能决策的自主网络。

b. 方法的详细步骤: (1). 部署生成式人工智能:通过多个设备上的多个生成式语言模型实现集体智能,这些模型可以与环境进行交互,根据目标进行任务规划和解决,并通过知识交换进行协作。

(2). 多个生成式语言模型的协作规划:多个生成式语言模型通过网络进行协作规划任务,充分利用不同模型的知识和不同设备的能力。模型可以从云端生成式语言模型或其他设备上的生成式语言模型获取领域特定知识。

(3). 规划和推理:生成式语言模型通过规划和推理来解决复杂任务和问题。通过提示工程和自洽策略等方法,模型可以进行推理和规划,并在多个路径中进行决策调整。

(4). 多个生成式语言模型的博弈和强化学习:使用博弈论模型来分析多个生成式语言模型之间的交互行为。同时,利用强化学习方法,模型可以与环境进行交互,并学习最佳的协作策略和通信协议。

(5). 语义信息和通信:通过语义通信,传输有用的信息来解决特定任务。生成式语言模型可以利用语义信息将多模态原始数据集成到一个共同的概念空间中,从而减少数据交换和存储的成本。

(6). 基于意图的网络:利用生成式语言模型扩展意图驱动网络的概念,将高级意图分解为低级任务,并指导相关执行者采取行动。多个网络设备利用生成式语言模型分析感知信息,并通过无线网络与其他设备进行通信和协作,直到完成任务目标。

(7). 挑战和研究路线:对实现无线集体智能的挑战进行了讨论,并提出了未来的研究方向。

以上是本文方法的详细步骤,通过部署生成式人工智能、多个生成式语言模型的协作规划、规划和推理、多个生成式语言模型的博弈和强化学习、语义信息和通信、基于意图的网络等步骤,实现了在无线网络中实现集体智能的目标。

实验设置:

- 实验设置(Experimental setting): 本文的实验设置主要是为了评估在无线通信问题中使用设备上的生成式语言模型(LLMs)的能力,并展示它们在实现端到端自主网络方面的潜力。实验中假设有一个具有4个用户的网络,这些用户在共享频谱中进行传输。每个用户具有特定的信道增益、带宽和噪声参数。实验通过创建独立的LLM实例来模拟每个用户,并使用GPT-4模型生成结果。实验的目标是降低网络能耗并保持各个用户的传输速率在一定范围内。通过比较实验结果和理论最小传输功率要求,可以评估LLMs在解决无线通信问题中的效果。实验结果显示,LLM-enabled agents能够在一定程度上实现节能目标,并保持用户的传输速率在要求范围内。然而,当代理数量增加时,当前的GPT-4模型在保持多个目标方面存在一定困难。因此,为了实现完全自主的意图驱动网络,需要训练具有无线领域特定知识的LLMs,并将其与实时无线环境进行校准和调整。此外,为了确保无线代理的可靠行为,还需要有效的幻觉避免方案。

实验结果:

实验结果和分析: 本文的实验旨在评估在无线通信问题中使用设备上的生成式语言模型(LLMs)的能力,并展示其在实现端到端自主网络方面的潜力。实验设置中,假设有4个用户在共享频谱中进行传输,每个用户具有不同的信道增益、带宽和噪声。通过使用GPT-4模型,研究人员创建了独立的LLM实例,并通过多轮游戏来评估它们在解决无线通信问题中的表现。

实验结果显示,LLM-enabled agents在第2轮成功实现了减少总功耗的目标,并且有3个用户将传输功率控制在理论最低功率以保持传输速率在要求范围内(除了用户1)。然而,在第3轮中,用户1和用户4违反了最低传输速率的目标。此外,当代GPT-4在处理多个代理时可能会遇到一些困难。

实验结果表明,LLMs具有分析无线环境、解决无线网络问题以实现网络运营目标的潜力。多代理LLMs可以在保持各自关键绩效指标的同时实现合作目标。为了实现完全自主的意图驱动网络,LLMs需要在电信领域语料库上进行训练,并与实时无线环境进行校准。此外,为了支持高效的网络升级,还需要将TelecomLLM与新的无线标准和功能进行调整。为了确保可信的代理行为,还需要有效的幻觉避免方案。

综上所述,实验结果表明LLMs在无线通信问题中具有潜力,并提出了进一步的研究方向和挑战。

P:14 07-05 RecallM: 一种用于时间上下文理解和问答的架构

- Title: RecallM: An Architecture for Temporal Context Understanding and Question Answering

- 论文简介: 本文提出了一种新的架构,通过创建可适应和可更新的长期记忆,为AGI系统提供了更好的时间理解能力。

- Authors: Brandon Kynoch, Hugo Latapie

- Affiliation: Brandon Kynoch: Cisco Systems Hugo Latapie: Cisco Systems

- Keywords: question answering, LLM, vector database, graph database, in-context learning, temporal relations, neuro-symbolic processing, long-term memory, knowledge graph

- Paper: Link to the paper Github: Link to the code

- 论文总结:

- (1): 本文的研究背景是大型语言模型(LLM)在人工智能系统中的应用。

- (2): 过去的方法主要是使用向量数据库来存储和检索信息,但在信念更新和时间理解方面存在困难。本文提出的RecallM架构通过使用图数据库,能够更好地处理这些问题。

- (3): 本文提出了RecallM架构,通过使用轻量级、时间感知的神经网络,捕捉和更新概念之间的高级关系。这是与向量数据库不可能实现的创新。

- (4): 本文在各种实验中展示了RecallM架构在时间理解方面的优越性能。此外,还提出了将RecallM与向量数据库相结合的混合架构(Hybrid-RecallM),以充分利用两种方法的优势。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了一种新的架构——RecallM,用于为AGI系统创建可适应和可更新的长期记忆,通过多种实验展示了RecallM架构的优势,特别是其提供的改进的时间理解能力。

b. 方法的详细步骤: (1). 使用命名实体识别(NER)模型或词性标注器来识别源文本中的概念标签。 (2). 使用词干提取获取概念标签的根词。 (3). 根据概念标签在源文本中出现的句子提取相关上下文。 (4). 将相邻的概念标签之间建立关系。 (5). 合并具有相同概念标签的所有概念。 (6). 将提取的概念、概念关系和相关上下文存储到图数据库中。 (7). 定期进行上下文修订,保留最相关和最近的信息。 (8). 使用少量提示来实现上下文修订。 (9). 使用图遍历算法查询图数据库以获取最相关的上下文。 (10). 构建聊天机器人的提示语句。 (11). 提出了一种混合架构,同时使用RecallM和传统的向量数据库方法。 (12). 使用判别模型选择更确定和简洁的回答。

以上是本文方法的详细步骤,通过这些步骤,RecallM架构实现了可适应和可更新的长期记忆,并提供了改进的时间理解能力。

实验设置:

- 实验设置(Experimental setting): 本文的实验设置主要包括以下几个方面:

(1). 使用TruthfulQA数据集进行实验,该数据集旨在测试上下文学习和系统更新对LLM内在信念的影响。通过对数据集进行单次遍历,使用引用的源网页从互联网上抓取包含问题相关的真实知识和事实的完整网页文章。在这个过程中,使用整篇文章作为知识更新步骤的文本语料库,而不仅仅是与问题相关的部分。这样可以展示模型在存在多余数据的情况下的能力,同时也证明了RecallM能够从这些来源中提取知识,并在需要时能够识别和提取相关概念。

(2). 使用TruthfulQA数据集的10%的网页文章进行知识更新,创建了一个包含10970个概念和40649个关系的深度复杂知识图。然后对这个子集进行定性测试,以及提出一些问题来展示模型对文本语料库的理解能力。

(3). 使用DuoRC数据集进行实验,该数据集包含了与电影情节相关的问题/答案对。使用这些电影情节进行知识更新,并测试模型在回答问题时是否能够超越所提供的段落内容,整合世界知识和常识推理来真实回答问题。在这个实验中,使用GPT-based autograder对模型的回答进行自动评分,并定义模型在DuoRC数据集上的准确率。

(4). 在DuoRC/ParaphraseRC数据集的50%上进行大规模测试,共计6725个问题/答案对。比较RecallM、Hybrid-RecallM和VectorDB方法的问答能力,并对结果进行评估。结果显示这三种方法的性能相似,其中VectorDB方法表现最好。然而,RecallM仍然能够回答许多VectorDB方法无法回答的问题。因此,作者认为在Hybrid-RecallM中使用的鉴别器模型在选择RecallM和VectorDB答案之间的效果不佳。

(5). 对比了本文提出的RecallM架构和2018年发表的BiDAF模型在DuoRC数据集上的准确率。同时,本文还尝试了两种不同的概念提取方法,分别是使用Fine-tuned的Distil-BERT模型和使用Staford的NLTK Part-of-Speech (POS) tagger。作者发现这两种方法各有优劣,NER模型能够识别更少的概念,但通常只能识别LLM没有预训练知识的概念;而POS tagger方法能够更好地泛化,但有时会尝试学习LLM已经非常了解的概念。同时,两种模型在代词消解方面都存在困难,无法捕捉到很多相关信息。

(6). 作者还提到了GPT autograder在测试过程中存在一些小的不一致性,但仍然认为它能够很好地评估问答系统的性能。

总结来说,本文的实验设置包括使用TruthfulQA和DuoRC数据集进行实验,对RecallM架构进行定性和定量测试,并与其他模型进行对比评估。同时,还尝试了不同的概念提取方法,并使用GPT autograder对模型的回答进行评分。

实验结果:

实验结果和分析: 通过一系列实验,本文展示了RecallM架构的优势,特别是其提供的改进的时间理解能力。首先,在TruthfulQA数据集上进行了实验,使用一次性方法对LLM的内在信念进行更新。实验结果表明,RecallM能够从网络文章中提取知识,并能够在问题回答中识别相关主题并提供准确的答案。此外,RecallM还能够处理多余的数据,并能够在LLM中覆盖模仿性错误。在DuoRC数据集上的实验进一步验证了RecallM的能力。尽管RecallM的性能略逊于向量数据库方法,但RecallM仍然能够回答许多向量数据库方法无法回答的问题。此外,本文还对RecallM架构中的混合方法进行了评估,结果显示如果使用完美的鉴别器模型来选择RecallM和向量数据库答案之间的答案,混合RecallM的最大可能得分为68.26%。最后,本文还对使用Distil-BERT模型和Staford的NLTK Part-of-Speech (POS)标注器进行概念提取的两种方法进行了比较,并讨论了它们的优缺点。

实验结果和分析: (1) 在TruthfulQA数据集上的实验结果表明,RecallM能够从网络文章中提取知识,并能够在问题回答中识别相关主题并提供准确的答案。RecallM的回答更加确切,相比于基础模型LLM,RecallM能够更好地更新LLM的内在信念。 (2) 在DuoRC数据集上的实验结果显示,RecallM能够回答许多向量数据库方法无法回答的问题。尽管RecallM的性能略逊于向量数据库方法,但RecallM仍然展现出了较好的回答能力。 (3) 混合RecallM的实验结果显示,如果使用完美的鉴别器模型来选择RecallM和向量数据库答案之间的答案,混合RecallM的最大可能得分为68.26%。 (4) 通过比较使用Distil-BERT模型和Staford的NLTK Part-of-Speech (POS)标注器进行概念提取的两种方法,发现它们各自具有不同的优势和劣势。NER模型能够识别LLM没有预训练知识的特定概念,而POS标注器的方法更具有泛化能力。然而,两种方法在代词消解方面都存在困难,无法捕捉到大量相关信息。

P:15 07-05 文本对齐是大规模自然语言处理任务的高效统一模型

- Title: Text Alignment Is An Efficient Unified Model for Massive NLP Tasks

- 论文简介: 该论文由UC San Diego的Yuheng Zha等人提出,通过文本对齐模型解决了大规模自然语言处理任务中的效率和性能问题。

- Authors: Yuheng Zha, Yichi Yang, Ruichen Li, Zhiting Hu

- Affiliation: UC San Diego(加州大学圣地亚哥分校)

- Keywords: large language models, text alignment, NLP tasks, efficiency, performance

- Paper: Link to the paper Github: Code

- 论文总结:

- (1): 该论文的研究背景是大规模语言模型在各种自然语言处理任务中的广泛应用。

- (2): 过去的方法通常采用下一个词预测的方式,但在许多任务中效率不高,需要大规模的模型参数并且性能不佳。本文提出了一种文本对齐模型,通过测量文本之间的信息对齐程度来解决这些问题。

- (3): 本文提出的文本对齐模型通过对RoBERTa进行轻量级微调,使用来自28个数据集的590万个样本进行训练。实验证明,该模型在多个任务上表现出高效性和强大的性能,并且比大规模模型和任务特定模型更优。

- (4): 该模型在包括文本理解、事实一致性评估和问题回答等多个任务上取得了优异的性能,支持其创新和贡献。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文提出了一种高效的文本对齐模型,通过测量文本对之间的信息对齐程度,可以应用于广泛的自然语言处理任务。

b. 方法的详细步骤: (1). 定义文本对齐:给定文本对(x1, x2),如果x2中的所有信息都由x1支持,则将x2与x1对齐。通过定义对齐函数f(x1, x2)将文本对(x1, x2)映射到对齐程度标签y。

(2). 对齐模型的训练:使用RoBERTa作为轻量级的基础语言模型,通过添加三个线性层来预测对齐输出的三种类型:二分类标签(ALIGNED, NOT-ALIGNED)的概率分布Pr(ybin),三分类标签(ALIGNED, CONTRADICT, NEUTRAL)的概率分布Pr(y3way),以及回归任务的实值分数yreg。使用交叉熵损失训练分类头部,使用均方误差损失训练回归头部。通过加权求和的方式将损失聚合为总损失Ltotal。

(3). 应用于多个下游任务:根据不同任务的特点,将任务转化为文本对齐问题,并根据对齐标签映射到相应的任务标签。例如,对于自然语言推理任务,将对齐标签映射为"entailment"、"contradiction"和"neutral"。对于信息检索任务,将候选文档作为x1,查询作为x2,通过Pr(ybin = ALIGNED)判断候选文档是否能够回答查询。对于问答任务,将上下文作为x1,问题和候选答案作为x2,通过Pr(ybin = ALIGNED)判断候选答案是否正确。对于生成任务,将生成上下文作为x1,生成的候选输出作为x2,通过Pr(y3way = ALIGNED)判断候选输出是否与上下文一致。

(4). 处理长输入:对于一些数据集中的长文本x1,采用分割-聚合的方法处理。将x1分割成一组chunk,使得每个chunk-sentence对的长度略低于语言模型的输入长度限制。然后对每个pair进行评估,并取具有最高ALIGNED概率或回归分数的输出进行聚合。

(5). 数据增强:为了增加训练集的多样性,除了使用下游任务的数据集外,还包括合成数据。对于一些QA数据集,通过去除上下文中的正确答案并生成错误答案来创建NOT-ALIGNED样本。对于WikiText-103语料库,通过神经机器翻译模型进行回译来创建合成的近义词样本。对于WikiHow摘要数据集,使用抽取式摘要生成器生成合成摘要。同时,还通过随机屏蔽25%的tokens并使用小型掩码语言模型进行填充来创建WikiText-103和WikiHow样本的负样本。

(6). 实验应用:将对齐模型应用于多个下游任务,包括语言对理解任务、事实一致性评估和带有无法回答问题的问答任务。

(7). 实验结果:在多个数据集上的实验结果表明,该对齐模型在效率和性能方面都表现出色,与具有更多参数的模型相比,能够达到或超过其性能。同时,该模型还可以作为轻量级模型的附加组件,用于提升大型语言模型在问答任务中的性能。

(8). 代码和数据:作者提供了代码和数据,供其他研究者使用。

(9). 结论:本文提出的文本对齐模型在多个NLP任务中展现了高效和强大的性能,为构建更高效的模型提供了一种新的思路。

实验设置:

- 实验设置(Experimental setting): 本文的实验设置包括将ALIGN应用于多个下游任务,包括语言对理解任务、事实一致性评估和带有无法回答问题的问答任务。在语言对理解任务中,使用ALIGN作为验证器的附加组件显著提高了GPT-3.5和FLAN T5的性能。在事实一致性评估中,ALIGN模型在大多数情况下优于GPT-3.5,并且在某些情况下甚至优于FLAN T5。在带有无法回答问题的问答任务中,ALIGN作为验证器的附加组件提高了GPT-3.5和FLAN T5的准确匹配得分和F1得分。实验中使用的数据集包括SQuAD v2、ACE-whQA和Simplified NQ。作为基线模型,使用FLAN T5和GPT-3.5进行对比实验。实验评估指标包括准确匹配得分、F1得分和ROC AUC。

实验结果:

实验结果和分析: 本文通过实验将ALIGN应用于多个下游任务,包括语言对理解任务、事实一致性评估和包含无法回答问题的问答任务。实验结果表明,在大多数情况下,将ALIGN作为验证器附加到GPT-3.5和FLAN T5上可以显著提高它们的性能(平均提高了17.94的精确匹配分数和15.05的F1分数),表明它在识别无法回答的问题方面是有效的。对于Simplified NQ数据集,将对齐验证器添加到GPT-3.5中会降低精确匹配和F1分数,但会提高AUC。这表明,虽然ALIGN在Simplified NQ数据集上产生了有意义的无法回答概率,但在SQuAD v2验证集上找到的阈值对于Simplified NQ并不理想。在Simplified NQ验证集上选择的最佳阈值的实验结果显示了精确匹配和F1分数的潜力提高,尽管这不再被视为零-shot设置。

实验结果和分析: (1) 将ALIGN作为验证器附加到GPT-3.5和FLAN T5上可以显著提高它们的性能,平均提高了17.94的精确匹配分数和15.05的F1分数。 (2) 在Simplified NQ数据集上,将对齐验证器添加到GPT-3.5中会降低精确匹配和F1分数,但会提高AUC。 (3) 在Simplified NQ验证集上选择的最佳阈值的实验结果显示了精确匹配和F1分数的潜力提高,尽管这不再被视为零-shot设置。

P:16 07-05 通过知识蒸馏的设备限制下的自监督语音表示学习用于关键词检测

- Title: On-Device Constrained Self-Supervised Speech Representation Learning for Keyword Spotting via Knowledge Distillation

- 论文简介: 该论文由爱丁堡大学的Gene-Ping Yang等人提出,通过知识蒸馏方法,使用受限的自监督语音表示学习(S3RL)架构解决了关键词检测任务中的设备限制和数据偏差的挑战。

- Authors: Gene-Ping Yang, Yue Gu, Qingming Tang, Dongsu Du, Yuzong Liu

- Affiliation: Gene-Ping Yang: 爱丁堡大学

- Keywords: self-supervised learning, knowledge distillation, dual-view cross-correlation, keyword spotting, on-device

- Paper: Paper Github: None

- 论文总结:

- (1):该论文的研究背景是自监督方法在语音相关任务中的有效性,但在关键词检测领域的偏差数据集上的应用仍然具有挑战。

- (2):过去的方法主要关注公共基准数据集上的性能,而忽略了关键词检测任务中的数据偏差和模型大小的问题。本文的方法通过知识蒸馏技术解决了这些问题,并提出了双视图交叉相关蒸馏和教师码书蒸馏两种新的蒸馏技术。

- (3):本文提出了一种基于知识蒸馏的S3RL模型,通过将知识从大型模型传递给轻量级模型,实现了在设备资源限制下构建关键词检测任务的自监督模型。其中,双视图交叉相关蒸馏方法考虑了样本之间和特征维度之间的相关性,而教师码书蒸馏方法利用了教师模型的码书来改善蒸馏过程。

- (4):该方法在Alexa关键词检测任务上表现出色,无论是在正常条件下还是在噪声条件下都取得了优异的性能,证明了知识蒸馏方法在关键词检测任务中构建自监督模型的有效性和效率。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了一种基于知识蒸馏的自监督语音表示学习方法,通过将知识从大型模型转移到小型模型,实现在设备资源限制下进行关键词检测任务。

b. 方法的详细步骤: (1). 基于知识蒸馏的自监督语音表示学习框架: - 使用教师-学生框架,将知识从复杂的教师模型传递给轻量级的学生模型。 - 教师模型生成隐藏特征序列,学生模型生成另一组隐藏特征,通过L1距离和余弦距离作为相似度度量,定义损失函数来鼓励学生模型学习教师模型的高保真表示。

(2). 提出的蒸馏机制: - 为了避免捕捉单个帧的变化,将焦点放在整个语音的特征上,而不是逐帧特征。 - 引入双视图交叉相关机制,通过在批次视图和特征视图上计算相关矩阵,减少特征维度冗余并推广对比操作。 - 通过计算教师和学生特征的批次视图和特征视图之间的相关矩阵,分别实现冗余减少和对比操作。 - 使用两个视图的综合损失函数,动态集成两个组件,消除手动调整权重的需求。

(3). 教师模型的代码本知识蒸馏: - 使用更强大的教师模型的代码本,将其知识蒸馏到学生模型中。 - 使用Wav2vec 2.0模型作为教师模型,该模型在LibriSpeech 960小时数据集上进行了训练。 - 在预训练阶段,使用教师模型的量化特征作为正样本和负样本,防止学生模型学习到捕捉细微噪声的代码本。 - 使用教师-学生鲁棒对比损失函数,进一步提高蒸馏计算效率。

(4). 总结: - 本文提出的方法通过知识蒸馏实现了在设备资源限制下进行关键词检测任务。 - 通过双视图交叉相关机制和教师模型的代码本知识蒸馏,提高了学生模型的表示能力和鲁棒性。 - 在Alexa关键词检测任务中,该方法在正常和噪声条件下表现出色,验证了知识蒸馏方法在关键词检测任务中的有效性。

实验设置:

- 实验设置(Experimental setting): 本文的实验旨在评估知识蒸馏对轻量级关键词检测中自监督语音表示学习的影响。首先,我们建立了一个没有知识蒸馏的基准模型,并使用学生架构作为骨干对其进行预训练和微调。结果表明,相对于正常和播放条件下的相对误拒绝率(FAR),所提出的基于双视图交叉相关的知识蒸馏方法分别比基准模型提高了14.6%和21.3%。接着,我们通过调整目标,使其在utterance级别上操作,并预测来自所有教师层的特征的加权和,以复制DistilHuBERT方法。结果显示,双视图方法在正常和播放(有噪声)条件下相对FAR上的改进超过了8%。我们还将教师码本集成到双视图交叉相关过程中进行知识蒸馏,并得到了一致的改进结果。进一步将学生模型大小减小到1.6M参数,发现这个超轻量级学生模型相对于相同模型大小的基准模型提高了10%,并且在相对FAR方面与21M参数基准模型相当。最后,我们进行了消融实验,比较了单视图(批次视图或特征视图)和双视图蒸馏的性能。结果表明,在正常测试条件下,批次视图、特征视图和双视图蒸馏产生了类似的结果,其中特征视图蒸馏的性能略优于其他两种方法。然而,在存在噪声的情况下,双视图蒸馏方法相对FAR超过了其他方法2.6%和3%,这表明批次视图中不同样本之间的对比性质对于学习更强大的模型是至关重要的。

实验结果:

- 实验结果和分析: 该研究通过实验评估了基于知识蒸馏的自监督语音表示学习(S3RL)在轻量级关键词检测中的效果。首先,作者建立了一个没有知识蒸馏的基准模型,并使用学生模型作为骨干进行预训练和微调。实验结果表明,相对于正常和播放条件下的基准模型,采用双视图交叉相关的知识蒸馏方法可以分别提高14.6%和21.3%的相对误拒率(FAR)。此外,作者还对DistilHuBERT方法进行了复现,并将其与双视图方法进行了比较。结果显示,在正常和播放(噪声)条件下,双视图方法相对于基准模型的相对FAR提高了8%以上。作者还将教师的码本集成到双视图交叉相关过程中,实验结果显示,在正常和播放条件下,相对FAR分别为0.850和0.762,相对于基准模型有了持续的改进。此外,作者进一步将学生模型的大小减小到1.6M参数,并发现这个超轻量级学生模型相对于相同大小的基准模型提高了10%的相对FAR,并且与21M参数基准模型相比具有可比的相对FAR。最后,作者进行了消融实验,比较了单视图(批次视图或特征视图)和双视图蒸馏的性能。结果显示,在正常测试条件下,批次视图、特征视图和双视图蒸馏产生了类似的结果,其中特征视图蒸馏的性能略优于其他两种方法。然而,在存在噪声的情况下,双视图蒸馏方法相对于其他方法提高了2.6%和3%的相对FAR,表明批次视图中不同样本之间的对比性质对于学习更强大的模型是至关重要的。

P:17 07-05 通过随机和自然语言句子的Strahler数的统计力学

- Title: Statistical Mechanics of Strahler Number via Random and Natural Language Sentences

- 论文简介: 本文通过统计力学分析,提出了计算自然语言句子树结构的Strahler数的上下限,并在大规模数据集上进行了实证测量,发现自然语言句子的Strahler数几乎总是3或4,与Strahler和Horton在河流分叉方面的研究结果相似。

- Authors: Kumiko Tanaka-Ishii and Akira Tanaka

- Affiliation: Kumiko Tanaka-Ishii: 东京大学 Akira Tanaka: 东京大学

- Keywords: Strahler number; Tree structure; Memory

- Paper: Link Github: None

- 论文总结:

- (1): 本文的研究背景是Strahler数在河流分叉和计算树等领域的应用。

- (2): 过去的方法主要集中在自然语言句子的认知负荷和短期记忆方面,缺乏对数据的统计力学特性的描述。

- (3): 本文提出了自然语言句子的Strahler数的数学定义,并发现其与句子长度呈对数增长关系,揭示了Strahler数作为一种树结构目标特征的统计基础。

- (4): 本文的方法在自然语言句子上取得了几乎3或4的Strahler数,该性能支持了他们的目标,并对Strahler数的统计基础进行了解释。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了计算自然语言句子树结构的Strahler数的上下限的方法,通过对大型数据集中的语法注释数据进行实证测量,发现自然语言句子的Strahler数几乎总是3或4,与Strahler和Horton在河流分叉中的情况类似。通过对随机树的数学分析,揭示了Strahler数作为一种普遍树结构特征的统计基础。

b. 方法的详细步骤: (1). 将依赖结构转化为短语结构,通过两种方法进行转化:Binary1和Binary2。 - Binary1方法使用由Reddy等人提出的语法,根据修饰语和被修饰语之间的语法关系对依赖树进行二元化。Binary1方法的优点是结果树结构反映了正确的句子结构,但适用性有限。 - Binary2方法基于修饰语与中心词的距离,通过两个简单的启发式规则对依赖结构进行二元化。Binary2方法不严格反映句子结构,但适用性较广。

(2). 对每个二元化后的树,计算其Strahler数。 - Strahler数是根据定义计算得到的,表示树的复杂度。

(3). 获取每个二元化方法得到的所有二元树的上下限。 - 对于给定的依赖树,可以通过不同的二元化方法将其转化为多个二元树。上下限分别是这些二元树的最大和最小大小。

(4). 计算每个节点的最大和最小Strahler数。 - 在每个内部节点上,有一种使得Strahler数最大或最小的二元化方法。最大化方法使得子树更接近完全树,而最小化方法使得子树更接近线性树。通过递归计算,可以得到Strahler数的上下限。

(5). 计算每个节点的平均上下限。 - 对于具有相同节点数的树的子集,可以计算其平均上下限。

(6). 通过与随机二叉树集合的比较,验证上下限的可靠性。 - 将计算得到的上下限与随机二叉树集合的上下限进行比较,验证其可靠性。

(7). 使用Universal Dependencies数据集进行实证测量。 - 使用Universal Dependencies数据集中的语法注释数据,计算自然语言句子的Strahler数的上下限。

(8). 计算随机树的上下限。 - 对于具有相同节点数的所有可能树,计算其平均上下限。

(9). 对比自然语言句子和随机树的上下限。 - 将自然语言句子的上下限与随机树的上下限进行对比,揭示Strahler数的统计基础。

(10). 总结方法的主要步骤和发现。 - 总结方法的主要步骤和发现,包括自然语言句子的Strahler数几乎总是3或4,以及Strahler数作为树结构特征的统计基础。

实验设置:

实验设置: 本文主要研究了自然语言句子树结构的Strahler数,并提出了计算该数的上下限的方法。实验采用了依存结构作为树结构的表示方式,并通过两种二叉化方法来计算Strahler数。第一种方法是使用手工设计的语法进行二叉化,第二种方法是基于启发式规则进行二叉化。通过这两种方法得到的二叉树可以计算出其对应的Strahler数。实验还计算了不同二叉化方法下的上下限,并与随机二叉树的上下限进行比较。实验结果表明,不同二叉化方法得到的Strahler数的上下限与随机二叉树的上下限具有相似性。

实验结果:

实验结果和分析: 本文通过对大规模数据集中的自然语言句子树结构进行统计力学分析,计算了自然语言句子的Strahler数的上下限,并进行了实证测量。实验结果表明,自然语言句子的Strahler数几乎总是3或4,与Strahler(1957)和Horton(1945)关于河流分叉的研究结果相似。根据该数值的理论,我们发现它是在特定模型下处理句子所需的最低内存量。对随机树的数学分析提供了关于Strahler数性质的进一步猜测,揭示了它不是一个常数,而是以对数增长。这一发现揭示了Strahler数作为一种普遍树结构目标的特征的统计基础。

(1). 实验结果表明,自然语言句子的Strahler数几乎总是3或4,与河流分叉的研究结果相似。

(2). 通过对随机树的数学分析,发现Strahler数不是一个常数,而是以对数增长。

(3). Strahler数被证明是处理句子所需的最低内存量。

(4). 通过对不同的二叉化方法进行实验,发现它们在计算Strahler数方面得到了非常相似的结果。

(5). 通过对不同二叉化方法得到的树集合进行计算,得到了上下限的平均值,与随机二叉树的上下限进行了比较。

(6). 通过动态规划计算了所有可能树的上下限,发现它们也与随机树的上下限具有可比性。

P:18 07-05 使用结构化注意力扩展上下文演示

- Title: Scaling In-Context Demonstrations with Structured Attention

- 论文简介: 本文由普林斯顿大学的Tianle Cai等人提出了一种名为SAICL的结构化注意力机制,用于解决大型语言模型在上下文学习中的限制问题。

- Authors: Tianle Cai, Kaixuan Huang, Jason D. Lee, Mengdi Wang

- Affiliation: 普林斯顿大学

- Keywords: large language models, in-context learning, attention mechanism, structured attention

- Paper: Link Github: None

- 论文总结:

- (1): 本文研究背景是大型语言模型在上下文学习中的能力受到模型架构的限制。

- (2): 过去的方法存在一些问题,如注意力的二次复杂度限制了演示的数量,模型对演示顺序敏感等。本文提出的方法通过结构化注意力机制解决了这些问题,并提出了一种更好的架构设计。

- (3): 本文提出的SAICL方法通过替换全注意力机制,设计了一种适用于上下文学习的结构化注意力机制。该方法消除了演示之间的不必要依赖关系,并使模型对演示的排列具有不变性。在元训练框架中评估了SAICL,并展示了与全注意力相当或更好的性能,同时获得了高达3.4倍的推理加速。此外,由于其线性特性,SAICL可以轻松扩展到数百个演示,并随着演示数量的增加而持续提高性能。

- (4): 本文在元训练框架中评估了SAICL方法,并与全注意力和Fusion-in-Decoder (FiD)基线进行了比较。实验结果表明,SAICL通常优于FiD,并能够与全注意力基线相匹配甚至超越其性能。此外,SAICL能够扩展到数百个演示,并在性能上持续改进。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文提出了一种用于上下文学习的结构化注意力机制SAICL,通过替换全注意力机制,去除个别演示之间的不必要依赖关系,并使模型对演示的排列不变,从而解决了大语言模型在上下文学习中的局限性。

b. 方法的详细步骤: (1). 编码器注意力融合方案:使用T5基线模型进行集成,每个实例只包含一个演示,并将处理后的标记独立地用于计算解码器中的逻辑回归,然后对逻辑回归进行平均。与此不同的是,对于直接集成方法,处理后的标记用于独立计算解码器中的逻辑回归,然后对逻辑回归进行平均。通过比较两种方法的结果,发现直接集成方法在k≥8时性能较差。

(2). 排列不变性:通过设计结构化注意力机制,使模型对演示的排列不变。具体方法是将演示分成G组,每组通过编码器独立处理,然后将处理后的标记连接起来送入解码器。通过将结构化注意力机制与SAICL和全注意力基线进行比较,发现结构化注意力机制在性能上略逊于直接集成方法。

以上是本文方法的详细步骤。

实验设置:

- 实验设置(Experimental setting): 本文提出了一种用于上下文学习的结构化注意力机制SAICL(Structured Attention for In-Context Learning),旨在解决大型语言模型(LLMs)在上下文学习中的一些挑战。实验中使用了T5和FiD作为基线模型,并对SAICL在不同任务类型和不同数量的演示示例下的性能进行了评估。实验结果表明,SAICL在保持线性复杂度的同时,通常能够优于FiD,并与T5基线实现可比较的性能。此外,通过增加演示示例的数量,可以进一步提高模型的性能。实验中使用了T5 large模型进行训练和测试,但也提到了将方法扩展到更大模型的未来工作。

实验结果:

实验结果和分析: SAICL(Structured Attention for In-Context Learning)是一种用于上下文学习的结构化注意力机制,通过替换全注意力机制并消除个别演示之间的不必要依赖关系,使模型对演示的排列具有不变性。在元训练框架中评估SAICL,并且结果表明,SAICL在获得高达3.4倍推理加速的同时,实现了与全注意力机制相当或更好的性能。与独立处理每个演示的强Fusion-in-Decoder(FiD)基线相比,SAICL始终表现更好。此外,由于其线性特性,SAICL可以轻松扩展到数百个演示,并随着扩展而持续提高性能。

在实验结果中,我们使用了表格1来展示实验结果,并总结了以下发现: - T5和FiD是强基线。实验结果表明,在Meta-ICL设置中,T5基线通常比GPT-2表现更好。这部分原因可能是T5编码器的双向注意力,相比于仅有解码器的模型(如GPT),允许每个演示利用来自其他演示的信息。对于FiD,实验结果显示它可以无缝适应上下文学习,并且通常在没有编码器中演示融合的情况下与全注意力机制的性能相匹配。 - SAICL在大多数设置中表现优于FiD。对于相同数量的演示,SAICL通常比FiD表现更好,同时保持相同的线性复杂度。与全注意力机制相比,SAICL通常可以匹配甚至超越其性能,同时更加高效。这些结果表明,SAICL能够实现与全注意力机制相当的演示融合,而完全禁用编码器中的信息交换(FiD)将导致性能下降。 - 增加演示数量k可以提高性能。实验结果显示,将k从16增加到64可以显著提高所有模型的性能(平均提高约3%)。这一观察结果与MetaICL论文中的发现相反,该论文表明在32个演示后性能改善趋于饱和。我们推测这是因为Min等人(2021)中使用的GPT-2模型的1024长度限制限制了有效上下文。这一发现表明,由于不合适的架构设计,使用更多演示来提高性能的潜力可能被低估。 - 不同类型任务的行为不同。我们注意到,我们测试的方法在不同任务上表现不同,并没有一种方法适用于所有任务。这是因为解决不同任务需要不同形式的信息。例如,在使用上下文学习解决分类任务时,确定标签空间和将分类问题转换为自然语言的格式至关重要。我们在HR→LR设置中检查了SAICL和FiD在不同类型任务上的行为。观察到SAICL在分类任务上的优势更为明显。我们推测这是因为分类任务需要更细微的关于格式和标签空间的知识,这受益于SAICL在编码器中实现的演示融合。这一观察结果也与Min等人(2022b)的发现相吻合,即上下文学习依赖于标签空间、输入格式和输入文本的分布。 - 关于模型大小的讨论。由于计算限制,本文使用了T5 large模型(770M)。将来可以将我们的方法扩展到更大的模型是一个有趣的研究方向。我们注意到,在Ye等人(2022a)的同时工作中,作者发现FiD相对于集成方法的优势在模型从T5 large扩大到T5 XL(3B)时更加显著。我们相信随着模型规模的扩大,SAICL和FiD的优势将不断增加。

P:19 07-05 通过联合优化文本和时刻实现零样本稠密视频字幕生成

- Title: Zero-Shot Dense Video Captioning by Jointly Optimizing Text and Moment

- 论文简介: 本文由KAIST AI、Korea University和Twelve Labs共同完成,提出了一种零样本稠密视频字幕生成方法,通过联合优化文本和时刻,解决了稠密视频字幕生成中的标注成本高的问题。

- Authors: Yongrae Jo, Seongyun Lee, Aiden SJ Lee, Hyunji Lee, Hanseok Oh, Minjoon Seo

- Affiliation: KAIST AI (韩国科学技术院人工智能研究所)

- Keywords: dense video captioning, zero-shot learning, moment localization, language generation, vision-language models

- Paper: Paper Github: None

- 论文总结:

- (1): 本文研究背景是稠密视频字幕生成任务需要大量标注的视频片段和文本,而标注成本高昂。

- (2): 过去的方法大多需要大量的标注数据,而本文提出的方法通过联合优化文本生成和时刻定位,实现了零样本稠密视频字幕生成,避免了对训练数据的依赖。

- (3): 本文提出了一种新的软时刻掩码和成对时序IoU损失,用于时刻定位和生成多个描述性字幕,从而提高了稠密字幕的丰富性。该方法通过最大化生成文本与视频中的时刻之间的匹配得分,将冻结的语言生成模型(GPT-2)与冻结的视觉-语言对比模型(CLIP)进行对齐。

- (4): 本文的方法在ActivityNet Captions基准测试中超过了零样本基线方法,甚至超过了最先进的少样本方法。此外,与监督方法相比,本文的方法在域外场景中表现出更强的鲁棒性。该方法的创新点在于通过对齐语言生成模型和视觉-语言对比模型,实现对视频的时序理解能力。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了一种零样本稠密视频字幕生成方法ZeroTA,通过联合优化文本和时刻,实现在测试时无需任何视频或注释的情况下,对输入视频中的事件进行定位和描述。

b. 方法的详细步骤: (1). 稠密视频字幕生成任务的定义:给定一个视频V,目标是确定一个函数F,将视频中的事件定位和描述,其中每个事件由一个字幕s和对应的时刻m表示。

(2). 零样本稠密视频字幕生成方法ZeroTA的设计:ZeroTA由两个模块组成。第一个模块是文本生成模块,利用一个冻结的语言模型(GPT-2)和可学习的前缀上下文,生成与特定时刻对应的文本。第二个模块是时刻定位模块,学习指定视频中的时刻参数,并确保时刻的多样性。

(3). 文本生成模块的优化:文本生成模块使用预训练的语言模型进行自回归生成,只优化前缀上下文参数,以使生成的文本与对应时刻对齐。优化过程中采用两个损失函数,分别是视觉损失和语言损失,用于增强生成文本与时刻的相似性和保持生成文本的自然性。

(4). 时刻定位模块的优化:时刻定位模块通过引入软时刻掩码,表示视频中的时间段,并与文本生成模块进行联合优化。为了捕捉视频中的多个不同事件,引入了一对一的时序IoU损失。

(5). 模型的端到端优化:将文本生成模块和时刻定位模块的损失函数结合起来,进行端到端的优化。

(6). 实验结果:实验证明,ZeroTA在零样本情况下超过了基线方法,并在广泛使用的ActivityNet Captions基准测试中超过了最先进的少样本方法。此外,ZeroTA在域外场景中表现出更强的鲁棒性。

(7). 研究意义:本研究揭示了语言生成模型和视觉-语言模型等广泛使用的模型之间的潜在联系,为理解视频的时间特征提供了新的能力。

实验设置:

- 实验设置(Experimental setting): 本文提出了一种零样本稠密视频字幕生成方法ZeroTA,用于在测试时通过仅优化输入来定位和描述视频中的事件。为了实现这一目标,作者引入了软时刻掩码和语言模型的前缀参数的联合优化。具体而言,作者通过最大化生成文本与视频中的时刻之间的匹配得分,将一个冻结的语言生成模型(GPT-2)与一个冻结的视觉-语言对比模型(CLIP)进行对齐。此外,作者还引入了一种成对的时间IoU损失,以便一组软时刻掩码可以捕捉视频中的多个不同事件。实验结果表明,ZeroTA在广泛使用的ActivityNet Captions基准数据集上超过了零样本基线,并且甚至优于最先进的少样本方法。此外,与监督方法相比,ZeroTA在域外场景中表现出更强的鲁棒性。这项研究揭示了将语言生成模型和视觉-语言模型进行对齐的潜力,以实现对视频的时间方面的理解能力。

实验结果:

实验结果和分析: 本文通过实验评估和分析了ZeroTA模型与基线模型以及当前最先进模型之间的性能差异。表1展示了我们的模型与零样本基线和具有更强监督的方法之间的性能比较。表2展示了在领域外设置下的性能比较。我们在附录C中添加了更详细的消融研究。

(1) ZeroTA模型通过联合优化文本和时刻,比两阶段方法更有效。在密集视频字幕生成任务中,我们的模型在ActivityNet Captions和YouCook2数据集上优于各种零样本基线。这些基线利用两阶段方法,通过分割组件和字幕生成组件来处理密集字幕生成。尽管这些基线的图像字幕和视频字幕组件直接使用额外的字幕数据和字幕损失进行训练,但与我们的方法相比,性能仍存在明显差距。这一观察结果突出了联合训练在文本生成和时刻定位中的关键作用,使得即使在没有数据的情况下,也能有效地生成密集字幕。

(2) ZeroTA模型优于最先进的少样本模型。与比我们更强监督的模型相比,我们观察到ZeroTA超过了少样本的Vid2Seq模型。值得注意的是,Vid2Seq在YT-Temporal-1B数据集上进行了预训练,该数据集包含了1800万个叙述视频,涵盖了10亿帧与转录的语音句子配对。值得注意的是,尽管我们的模型从未访问过视频数据或时序注释,但我们在比Vid2Seq使用1%训练数据进行微调时取得了更好的性能。

(3) 目标任务的文本空间和CLIP的文本空间需要匹配。YouCook2数据集与ActivityNet Captions呈现不同的趋势。在这里,我们的方法在少样本的Vid2Seq模型下表现不佳。这种差异可以归因于数据集固有的不同语言注释风格。ActivityNet Captions通常包含简要描述视觉内容的传统字幕,例如“啦啦队员站在路边。”相比之下,YouCook2以任务导向的指导性文本注释为特点,如“在面包上放一片奶酪。”由于我们的模型依赖于使用传统图像字幕进行预训练的CLIP,生成的文本类似于这些字幕。这种生成字幕的风格与YouCook2的真实字幕冲突,从而降低了性能。

(4) ZeroTA模型在领域外设置中表现出较强的鲁棒性。我们的方法在领域外设置中展示了比完全训练的最先进模型更强的鲁棒性。与针对目标领域进行优化的微调模型不同,我们的零样本方法在不同领域之间保持了性能。其固有的领域无关性使其具有灵活性,避免了专门模型的过拟合问题。我们的零样本方法设计上不涉及与数据集相关的文本或时序注释。因此,它没有机会学习数据集的特定输出文本和时刻的风格。虽然这个限制可以通过各种方式来解决,包括少样本学习,但我们将其保留为未来的工作。

综上所述,本研究提出了一种新颖的零样本密集视频字幕生成方法ZeroTA,它利用软时刻掩码和成对时序IoU损失进行端到端的时序定位。我们的方法不仅超过了各种零样本基线,还在广泛使用的ActivityNet Captions基准测试中优于最先进的少样本方法。此外,与完全监督模型相比,它在领域外场景中展示了更强的鲁棒性,展示了它对多样和以前未见的视频数据的适应能力。这项研究不仅提出了一种零样本密集视频字幕生成的先导方法,还为零样本对齐语言和视觉模型的潜力提供了启示。通过结合不同模态的预训练模型的能力,我们可以开启理解视频时序方面的新能力。这些贡献推动了密集视频字幕生成领域的发展,并为零样本对齐语言和视觉模型的未来研究提供了有价值的见解。

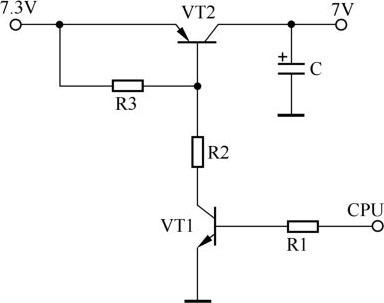

P:20 07-05 芯片组云:构建用于服务大型生成式语言模型的AI超级计算机

- Title: Chiplet Cloud: Building AI Supercomputers for Serving Large Generative Language Models

- 论文简介: 本文提出了一种基于芯片组的ASIC AI超级计算机架构,通过优化每个生成的令牌的总拥有成本,为大型生成式语言模型的服务降低了部署和运行的总成本。作者来自华盛顿大学和微软公司,采用了芯片组云架构,利用成千上万个复制的芯片加速器模块协同执行令牌生成,实现了前所未有的每个令牌的拥有成本。

- Authors: Huwan Peng, Scott Davidson, Richard Shi, Shuaiwen Leon Song, Michael Taylor

- Affiliation: 华盛顿大学

- Keywords: Chiplet Cloud, AI supercomputers, generative language models, total cost of ownership (TCO)

- Paper: Link Github: None

- 论文总结:

- (1): 本文研究背景是大型生成式语言模型的硬件效率成为限制其民主化的主要因素。

- (2): 过去的方法使用通用硬件平台(如GPU)来运行生成式语言模型,但随着模型规模和上下文长度的增加,以及摩尔定律的放缓,硬件效率成为限制模型服务的因素。本文的方法通过芯片组云架构,利用芯片加速器模块协同执行令牌生成,优化了每个生成的令牌的总拥有成本。

- (3): 本文提出了一种基于芯片组的ASIC AI超级计算机架构,通过将所有模型参数存储在芯片上的SRAM中,消除了带宽限制,并利用软件映射来利用计算中的并行性,以克服潜在的数据通信开销。同时,提出了一种综合的设计方法,通过硬件探索和软件评估,寻找TCO per performance最优的系统映射策略。

- (4): 本文在四个流行的大型生成式语言模型上进行了设计和评估,结果显示与A100 GPU和TPUv4相比,Chiplet Cloud在TCO/Token上分别实现了高达94倍和15倍的改进。这显著降低了实现现代大型生成式语言模型的成本。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文提出了Chiplet Cloud架构,通过利用芯片模块协同进行标记生成,以降低大型生成语言模型的总体成本,实现在现实世界中部署和运行这些应用程序的成本降低。

b. 方法的详细步骤: (1). 针对现有云硬件平台在大型生成语言模型上的效率低下问题,提出了使用专用硬件构建ASIC超级计算机的解决方案。 (2). 通过将模型参数全部放入芯片模块的片上静态随机存储器(SRAM)中,消除了带宽限制,实现了高效的标记生成。 (3). 使用芯片模块可以调节芯片尺寸,改善系统成本,并利用软件映射来利用计算中的并行性,以克服潜在的数据通信开销。 (4). 提出了一种综合设计方法,通过硬件和软件的联合空间中准确探索各种主要设计权衡,生成详细的性能-成本分析,并输出帕累托前沿。 (5). 在市场上的四个流行的大型生成语言模型上设计和评估了Chiplet Cloud,结果显示与A100 GPU云和TPUv4云相比,Chiplet Cloud在TCO/Token方面分别可以实现高达94倍和15倍的改进,显著降低了现实中部署现代大型生成语言模型的成本。

实验设置:

- 实验设置(Experimental setting): 本文提出了一种基于芯片云的ASIC AI超级计算机架构,用于为大型生成式语言模型提供高效的服务。该架构利用了芯片模块的独特方法,通过协同执行令牌生成来实现每个令牌的前所未有的总拥有成本(TCO)优化。为了实现这一目标,文中提出了一种综合的设计方法,可以准确地探索硬件和软件的联合设计空间,并生成Pareto前沿的详细性能成本分析。作者在四个市场上流行的大型语言模型上设计和评估了芯片云,结果显示与A100 GPU云和TPUv4云相比,芯片云在TCO/Token方面分别可以实现高达94倍和15倍的改进。

(1). 芯片云架构:芯片云采用基于芯片模块的ASIC AI超级计算机架构,通过协同执行令牌生成来实现TCO优化。

(2). 软件优化:使用软件优化器对生成式语言模型进行优化,包括张量并行和流水线并行等优化策略。

(3). 芯片云系统性能建模:通过分析数据流和计算延迟,对芯片云系统的计算延迟进行建模,并估计平均核心计算能力。

(4). 芯片云系统通信建模:对芯片云系统中芯片之间的数据通信延迟进行建模,包括在服务器内和服务器间的通信。

(5). TCO模型:使用改进的TCO模型计算系统的总拥有成本,包括资本支出和运营费用。

(6). 设计探索:对四个市场上流行的大型语言模型进行设计探索,包括不同的上下文长度和输入批次大小。

(7). 设计方法论:提出了一种综合的设计方法,可以准确地探索硬件和软件的联合设计空间,并生成Pareto前沿的详细性能成本分析。

(8). 设计优化:通过综合考虑硬件设计和软件优化,找到最适合的设计点,以实现最佳的TCO/Token性能。

(9). 实验评估:在四个市场上流行的大型语言模型上进行了实验评估,结果显示芯片云在TCO/Token方面具有显著的改进。

实验结果:

实验结果和分析: 该论文提出了一种基于芯片模块的ASIC AI超级计算机架构Chiplet Cloud,用于高效地为大型生成式语言模型提供服务。通过使用成千上万个复制的芯片模块协同进行标记生成,Chiplet Cloud架构能够以前所未有的每标记总拥有成本(TCO)来扩展云计算。该架构的关键特点是能够将所有模型参数放入芯片模块的片上静态随机存取存储器(SRAM),以消除带宽限制。通过使用芯片模块,可以适度减小芯片尺寸以改善系统成本,并利用软件映射来利用计算中的并行性,以克服潜在的数据通信开销。

论文在四个市场上的流行的大型语言模型上设计和评估了Chiplet Cloud。与A100 GPU云和TPUv4云相比,实验结果显示,Chiplet Cloud在TCO/Token方面分别可以实现高达94倍和15倍的改进。这显著降低了实际服务现代大型语言模型的成本。

论文还提出了一种综合的设计方法,用于在硬件和软件的联合设计空间中准确探索各种主要设计权衡,并在所有有效的设计点上生成详细的性能成本分析。通过该方法,可以找到最适合给定约束条件和优化目标的设计。

实验结果表明,对于不同的模型和优化目标,Chiplet Cloud可以实现低延迟、高吞吐量和低TCO/Token。通过合理选择芯片尺寸、服务器设计和软件映射策略,可以实现最佳的性能和成本平衡。

总之,Chiplet Cloud架构在为大型生成式语言模型提供服务方面具有显著的优势,可以降低系统成本并提高性能。该论文提出的综合设计方法可以帮助设计人员找到最适合其需求的设计,并为云规模架构的设计提供了有价值的参考。

P:21 07-05 无监督的整形手术社交媒体帖子情感分析

- Title: Unsupervised Sentiment Analysis of Plastic Surgery Social Media Posts

- 论文简介: 本研究由Northwestern University的Alexandrea K. Ramnarine提出,采用无监督学习方法,通过对社交媒体帖子进行情感分析,解决了如何预测用户对整形手术的情感态度的问题。

- Authors: Alexandrea K. Ramnarine

- Affiliation: Northwestern University(西北大学)

- Keywords: Natural language processing, unsupervised analysis, social media, Twitter, Reddit, plastic surgery

- Paper: Link Github: None

- 论文总结:

- (1): 本文的研究背景是社交媒体上关于整形手术的用户帖子数量庞大,如何有效地分析这些帖子的情感态度是一个重要问题。

- (2): 过去的方法主要是基于监督学习,需要手动标记数据,但是由于数据量大,标记工作繁琐且耗时。本文提出的无监督学习方法可以自动对社交媒体帖子进行情感分析,避免了手动标记的问题,并且在情感任务上取得了较高的准确率。

- (3): 本文采用了自然语言处理和机器学习的方法,通过词频-逆文档频率(TF-IDF)和聚类算法(k-means)对社交媒体帖子进行特征提取和分组,然后使用深度学习模型进行情感预测。这种无监督学习方法在社交媒体文档标记方面具有潜力。

- (4): 本文的方法在预测用户对整形手术的情感态度方面取得了近90%的准确率,比传统的监督学习方法更高。这表明无监督学习在社交媒体文档标记方面是可行的,并且具有较高的性能和创新性。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本研究利用无监督学习方法对社交媒体上的整形手术帖子进行情感分析,通过使用TF-IDF方法创建特征并应用t-SNE、k-means聚类和LDA等算法,实现对帖子的无监督分组,并通过简单的深度学习模型对用户情感进行预测。

b. 方法的详细步骤: (1). 使用Python 3.8版本的snscrape包运行命令行脚本,从Reddit和Twitter上抓取相关的社交媒体帖子。Reddit的查询包括三个不同的subreddits,分别是"PlasticSurgery"、"CosmeticSurgery"和"BotchedSurgeries",每个subreddit最多抓取8000或4000个最新帖子。Twitter的查询包括"plasticsurgery"、"liposuction"、"lipinjections"、"botox"和"nosejob"等关键词,最多抓取8000个热门推文。抓取的数据保存为JSON文件,并读入相应的Pandas数据框。

(2). 对Reddit和Twitter的数据进行预处理和合并。预处理步骤包括将文本转换为小写、去除标点符号、去除表情符号和其他Unicode字符、分词、去除英文停用词和词干提取。合并后的语料库数据框根据标识号、类别、文本和标题列进行连接。

(3). 对合并后的语料库进行TF-IDF向量化。在向量化之前,还需要进行额外的预处理步骤,包括去除重复数据和Unicode字符。

(4). 应用t-SNE、k-means聚类和LDA等算法,学习出关键词和生成主题。这些算法可以帮助无监督地对文档进行分组和主题提取。

(5). 使用简单的深度学习模型对帖子的情感进行预测。通过对帖子进行特征提取和情感分类,可以实现对用户情感的预测。实验结果表明,无监督学习方法在情感分析任务上的准确率高于有监督学习方法。

综上所述,本研究提出了一种利用无监督学习方法对社交媒体帖子进行情感分析的方法,通过对文本进行特征提取和聚类分析,实现了对用户情感的预测。这种方法可以为自然语言处理任务中的社交媒体文档标注提供一种可行的选择。

实验设置:

- 实验设置(Experimental setting): 本文的实验设置主要包括以下几个步骤:

- 数据预处理:首先,将社交媒体平台上的用户帖子进行向量化处理,以便进行后续的无监督分析。使用词频-逆文档频率(TF-IDF)方法对文档进行特征提取,生成特征向量。

- 无监督分析:使用t-SNE(t分布随机邻域嵌入)、k-means聚类和潜在狄利克雷分配(LDA)等方法对向量化后的文档进行无监督分析。通过t-SNE方法可视化文档类别的分布情况,将文档聚类成不同的组。通过k-means聚类方法将文档映射到t-SNE空间中的不同簇。使用LDA方法进一步支持无监督情感标签的分配。

- 情感标签分配:通过k-means聚类方法将文档分成三个平衡的组,分别对应积极、消极和中性情感。使用LDA方法对每个聚类的关键词进行分析,将k-means聚类的结果与LDA的结果相结合,为每个聚类分配情感标签。

- 模型训练和评估:使用简单的深度学习模型进行有监督的文档分类和无监督的情感分析任务。使用30%的dropout正则化,训练模型并评估其性能。比较有监督分类和无监督情感分析任务在综合语料库上的表现。

总体而言,本文的实验设置包括数据预处理、无监督分析、情感标签分配和模型训练等步骤,旨在通过无监督学习方法对社交媒体文档进行情感分析,并比较有监督分类和无监督情感分析任务的性能差异。

实验结果:

实验结果和分析: 该研究使用无监督学习方法对社交媒体上的整形手术帖子进行情感分析。通过使用词频-逆文档频率(TF-IDF)方法对文档进行特征提取,并结合t-SNE、k-means聚类和潜在狄利克雷分配(LDA)等方法,对Reddit和Twitter的语料库进行了分析。实验结果表明,使用简单的深度学习模型,可以以近90%的准确率预测用户对整形手术的负面、正面或中性情感。此外,相比于基本的监督文档分类任务,无监督学习在情感分析任务上表现更好。因此,无监督学习可以被认为是对社交媒体文档进行自然语言处理任务标注的可行选择。

具体实验结果如下: 1. t-SNE分析结果显示,Reddit的文档相互之间更相似,而Twitter的文档则聚集在分布的底部和左侧。与整形手术相关的文档最相似,而Botched Surgery子论坛的文档则形成一个较小的独立聚类。 2. k-means聚类结果显示,生成了八个聚类,突出了强烈的异常文档群体、Twitter标签之间的差异以及Reddit文档和整形手术相关文档之间的相似性。 3. LDA主题建模结果显示,通过对八个主题的前20个词进行分析,可以将这些词与k-means的结果相结合,为每个聚类分配情感标签。根据关键词的情感倾向,将聚类分为负面、中性和正面情感。 4. 使用简单的深度神经网络模型进行监督文档分类和无监督情感分析的对比实验结果显示,无监督情感分析的性能优于监督文档分类。在情感分析任务中,模型对中性情感的预测效果最好,对负面情感的预测效果相对较差。

综上所述,该研究通过无监督学习方法对社交媒体上的整形手术帖子进行情感分析,并取得了较好的预测准确率。这一研究结果表明,无监督学习在标注社交媒体文档的自然语言处理任务中具有潜在的应用价值。

P:22 07-05 SkipDecode:通过批处理和缓存实现自回归跳过解码以提高LLM推理效率

- Title: SkipDecode: Autoregressive Skip Decoding with Batching and Caching for Efficient LLM Inference

- 论文简介: 本文提出了一种名为SkipDecode的方法,由微软研究院的Luciano Del Corro等人提出,通过批处理和缓存技术,解决了自回归大型语言模型(LLM)在推理过程中的高计算成本和延迟问题。

- Authors: Luciano Del Corro, Allie Del Giorno, Sahaj Agarwal, Bin Yu, Ahmed Awadallah, Subhabrata Mukherjee

- Affiliation: 微软研究院

- Keywords: autoregressive language models, early exit strategies, batch inference, key-value caching

- Paper: Link Github: None

- 论文总结:

- (1): 本文的研究背景是自回归大型语言模型在自然语言生成任务中取得了显著进展,但由于逐个生成标记的自回归过程,导致计算成本和延迟较高。

- (2): 过去的方法主要是通过提前终止计算来减少计算成本,但这些方法无法与批处理和键值缓存技术兼容,限制了它们的实际应用。

- (3): 本文提出了一种名为SkipDecode的方法,通过为每个批次中的每个标记设置统一的退出点,解决了批处理推理和键值缓存的限制。该方法还通过逐渐减少退出点,使后续标记能够从前面标记的计算资源中受益,从而提高了推理效率。

- (4): 本文在多个任务上进行了实验,结果表明SkipDecode方法在保持性能的同时,实现了2倍到5倍的推理加速。该方法对于13亿和67亿参数的OPT模型都适用,并且与批处理和键值缓存优化技术兼容。

方法部分:

方法详细介绍(Method detailed introduction):

a. 一句话概览:本文提出了一种名为SkipDecode的简单而有效的令牌级早期退出方法,旨在与批量推理和KV缓存优化技术无缝配合,以提高大型语言模型(LLM)的推理效率。

b. 方法的详细步骤: (1). 批量推理:利用硬件(如GPU和TPU)提供的并行性,通过同时处理多个输入样本来提高计算效率,减少延迟并提高吞吐量。

(2). 早期退出策略的挑战:将现有的令牌级早期退出策略应用于批量推理时,由于批次中的令牌具有不同的退出点,会面临挑战。需要持续计算,直到每个批次成员和每个位置的最后一个令牌被处理完毕。这降低了批量大小超过1时的潜在优势,从而削弱了并行计算的优势。

(3). SkipDecode方法:为了解决上述挑战,本文提出了一种方法,为批次中的每个令牌在给定序列位置上指定一个固定的退出点。这种策略确保在某个序列位置上处理所有批次令牌的过程同时结束。因此,它确保了在非平凡的批处理场景中,在评估过程中观察到的所有理论优势在生成过程中得到充分实现。

(4). 退出点的分配:为了控制计算成本,本文预先指定了最大和最小退出点(每个令牌应经过的最大和最小层数),通过活动模型参数的数量来控制计算成本。退出点在序列中的分配必须是单调递减的,以确保前一个令牌的计算至少与当前令牌一样多,从而避免任何额外的计算。

(5). 退出点的递减函数:本文使用预定义的函数逐步为序列中的令牌分配退出点。在评估阶段,使用线性衰减函数进行测试,该函数受最小和最大层数的限制。其他函数(如幂律函数)可能会导致更大的加速,这将是未来研究的主题。

(6). 实验过程:首先,使用完整的计算能力处理提示中的所有令牌,这可以通过批处理高效地完成,因为提示处理中不涉及生成。从提示长度+1开始,开始自回归令牌生成,同时逐渐减少作用于任何令牌的活动层数,以最大和最小层数为计算预算预先指定。

以上是本文方法的详细步骤。

实验设置:

- 实验设置(Experimental setting): 本文使用了OPT [23]解码器的语言模型,分别包括1.3b和6.7b参数的模型,分别具有24层和32层。实验使用了三个基准文本生成数据集:E2E [13]、Reddit-TLDR [21]和CNN-DM [6]。作者使用metaseq代码库实现了SkipDecode方法。实验中,作者通过调整最大和最小层数的不同组合来实现不同程度的加速。作者通过在e2e数据集上进行超参数调优,选择了每个指定加速度下的最佳组合。实验中使用了一些配置,如最大序列长度、最小层数、预热层数和学习率等。训练过程中,作者使用了每个数据集的中位数训练提示长度,并确保所有层都被处理,以模拟所需的生成行为。在生成过程中,作者使用了beam size为1,top-sampling为0.7,温度为0.3。训练过程中,作者在学习率范围为2e-4到8e-6之间进行了扫描。具体的数据集信息如下:

- Reddit-TLDR [21]:这是一个摘要数据集,包括117,000个训练样本、6450个评估样本和6550个测试样本。训练提示的中位数长度为348个标记。作者设置了最大提示长度为512个标记,最大序列长度为1024个标记。在训练过程中,作者使用了200个预热步骤,有效训练批次为32,训练了3个epochs。上下文和完成之间的分隔符为"\nTl;dr\n"。

- CNN Daily Mail [6]:这是一个要求根据文章输入写摘要的数据集。它是一个大型数据集,包括287,113个训练样本、13,368个评估样本和11,490个测试样本。训练提示的中位数长度为788个标记。作者将最大序列长度设置为2048个标记,最大提示长度设置为1024个标记。预热更新设置为650次,有效批次大小为32,训练了2个epochs。上下文和完成之间的分隔符为"\nTl;dr\n"。

实验结果:

- 实验结果和分析:

本文提出的SkipDecode方法在三个基准文本生成数据集上进行了实验,分别是E2E、Reddit-TLDR和CNN-DM。实验结果表明,SkipDecode方法在不同配置下都能够获得2倍到5倍的推理加速,并且在各项任务中几乎没有回归。这些实验结果是在1.3亿和6.7亿参数的OPT解码器语言模型上获得的,其中24层和32层分别对应不同的模型。SkipDecode方法与批处理和KV缓存优化技术完全兼容,且实现简单易用。

此外,实验还发现,通过调整每个令牌的最大和最小层数,可以实现不同程度的加速。通过在e2e数据集上进行超参数调优,选择了最佳的最大和最小层数组合,以及预热层数和学习率,来实现指定的加速。需要注意的是,实际的加速可能会因为生成的令牌数量无法提前预测而略有变化,但计算预算严格受到每个数据集的最大序列长度所分配的最小层数的限制。

在实验过程中,本文的方法不需要对Transformer架构进行任何额外的修改,无论是在训练还是生成过程中。实验结果还展示了在每个数据集上的生成示例,其中使用了beam size为1、top-sampling为0.7和温度为0.3的设置。对于训练过程,使用了学习率从2e-4到8e-6的范围进行了扫描。

综上所述,实验结果表明,SkipDecode方法在各项指标上都取得了显著的推理加速效果,并且与批处理和KV缓存优化技术完全兼容。

P:23 07-05 ODD: 一种基于自然语言处理的阿片类药物相关异常行为检测的基准数据集

- Title: ODD: A Benchmark Dataset for the NLP-based Opioid Related Aberrant Behavior Detection

- 论文简介: 本文介绍了一个名为ODD的新型生物医学自然语言处理基准数据集,该数据集用于识别患者电子健康记录中的与阿片类药物相关的异常行为,并将其分类为九个类别。作者采用了两种最先进的自然语言处理模型来识别ORAB,并发现prompt-tuning模型在大多数类别中表现优于fine-tuning模型。

- Authors: Sunjae Kwon, Xun Wang, Weisong Liu, Emily Druhl, Minhee L. Sung, Joel I. Reisman, Wenjun Li, Robert D. Kerns, William Becker, Hong Yu

- Affiliation: UMass Amherst (第一作者单位)

- Keywords: Opioid related aberrant behaviors, natural language processing, benchmark dataset, ORAB detection

- Paper: Link Github: [None]

- 论文总结:

- (1): 本文的研究背景是阿片类药物滥用和过量引发的危机对美国造成了巨大的健康和经济负担。

- (2): 过去的方法主要通过监测药物使用和调查问卷来评估ORAB,但这些方法无法扩展且无法涵盖所有异常行为的范围。本文提出了一种基于自然语言处理的方法,利用电子健康记录中的信息来识别ORAB。

- (3): 本文设计了一个专家注释的数据集ODD,用于识别患者电子健康记录中的ORAB,并将其分类为九个类别。作者采用了两种最先进的自然语言处理模型来识别ORAB,并发现prompt-tuning模型在大多数类别中表现优于fine-tuning模型。

- (4): 本文的方法在ORAB检测任务上取得了较好的性能,尤其在少见类别(Suggested aberrant behavior、Diagnosed opioid dependency和Medication change)上的性能提升更为显著。然而,少见类别仍有较大的性能改进空间。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文介绍了一种基于自然语言处理的方法来检测与阿片类药物相关的异常行为,并提出了一个名为ODD的专家标注数据集,用于识别患者的电子健康记录中的异常行为。

b. 方法的详细步骤: (1). 构建预训练语言模型(LM)的异常行为检测模型: - 使用预训练语言模型的微调模型,将输入文本通过微调模型得到第一个标记"[CLS]"的隐藏表示向量h0,然后使用分类器计算输出标签y的概率分布。 - 由于微调模型需要大量的标注样本才能达到高性能,因此在ODD中的不常见类别可能成为性能瓶颈。

(2). 使用基于提示的微调模型来提高性能: - 基于提示的微调模型利用模板将下游任务转化为语言建模问题,通过蒙版语言建模和预定义的标签词集合,实现了有效的少样本学习能力。 - 在本研究中,使用每个类别的全名来构建提示文本p,将提示文本与输入文本x连接起来,并通过提示文本微调模型进行处理。 - 计算与每个类别对应的蒙版标记的语言模型输出为正词或负词的概率,将正词定义为'yes',负词定义为'no'。因此,第i个类别c_i的'yes'概率可以解释为c_i是否包含在输入文本x中的概率。

(3). 实验结果: - 实验结果表明,基于提示的微调模型在大多数类别上优于微调模型,尤其在不常见的类别(如Suggested aberrant behavior、Diagnosed opioid dependency和Medication change)上的性能提升更为显著。 - 最佳模型在面积下的精确率-召回率曲线上达到了最高的83.92%,但不常见的类别仍有很大的性能提升空间。

实验设置:

- 实验设置(Experimental setting): 本文使用了一个名为ODD的生物医学自然语言处理基准数据集,该数据集包含750多个公开可用的电子健康记录笔记。ODD数据集的目标是从患者的电子健康记录笔记中识别和分类与阿片类药物相关的异常行为。数据集将异常行为分为九个类别,包括确认的异常行为、建议的异常行为、阿片类药物、适应症、已诊断的阿片类依赖、苯二氮平类药物、药物变化、与中枢神经系统相关和社会健康决定因素。

作者使用了两种最先进的自然语言处理模型(微调预训练语言模型和提示微调方法)来识别异常行为。实验结果表明,在大多数类别中,提示微调模型的性能优于微调模型,尤其是在不常见的类别(建议的异常行为、已诊断的阿片类依赖和药物变化)中。最佳模型在面积下的精确率-召回率曲线上达到了最高的83.92%的性能,但不常见的类别仍有很大的性能提升空间。

实验采用了五折交叉验证,并报告了平均性能和标准差。微调模型使用了二元交叉熵作为损失函数,而提示微调模型使用了分类交叉熵作为损失函数。优化器选择了AdamW。在超参数设置方面,进行了网格搜索,选择了最佳性能的超参数。最终选择的超参数为学习率为3e-5,批次大小为8,训练轮数为3。

为了评估模型之间性能的统计显著性,采用了学生t检验。所有实验中,随机种子保持为0。实验在一台NVIDIA P40 GPU上进行,使用的操作系统为CentOS 7版本。

实验结果:

实验结果和分析: 根据实验结果表格4的数据,通过对实验模型进行五折交叉验证,得出以下结论: 1. 在宏平均AUPRC方面,性能范围为73.02%至83.92%。 2. 在BioClinicalBERT和BioBERT中,基于提示的微调模型在性能上优于微调模型,分别具有4.00%p和9.38%p的较大优势。其中,基于BioClinicalBERT的模型性能更高,这是因为BioClinicalBERT的预训练语料库包含了与目标数据库MIMIC-IV相同医院的电子健康记录笔记。 3. 不同类别之间的性能差距较大。例如,在BioClinicalBERT微调模型中,性能最高的类别(中枢神经系统相关)为98.21%,比最低类别(药物变化)的44.45%高出一倍以上。这种性能差距与实例数量有关,主导类别(阿片类药物和中枢神经系统相关)的性能非常高,分别为97.09%和98.21%,而不常见类别的检测性能较低,分别为44.74%(建议的异常行为)、69.85%(诊断的阿片类药物依赖)和44.45%(药物变化)。 4. 基于提示的微调在几乎所有环境中都有性能提升(18个案例中的17个),唯一例外是BioClinicalBERT中的中枢神经系统相关类别,性能差异微乎其微(-0.03%p)。引入基于提示的微调显著提高了性能,特别是在不常见类别中。基于BioClinicalBERT和BioBERT的基于提示的微调模型在建议的异常行为类别上的性能分别提高了7.04%p和17.54%p。在诊断的阿片类药物依赖类别中,基于BioClinicalBERT和BioBERT的基于提示的微调模型性能分别提高了3.18%p和16.75%p。最后,在药物变化类别中,性能提高了超过20%p。尽管取得了这些进展,但不常见类别仍然需要进一步提高性能。 5. 实验中采用了二元交叉熵作为微调模型的损失函数,采用了分类交叉熵作为基于提示的微调模型的损失函数。优化器选择了AdamW。超参数设置方面,进行了网格搜索,选择了在BioClinicalBERT微调环境的第一个折叠上取得最佳性能的超参数,即学习率为3e-5,批大小为8,迭代次数为3。 6. 为了评估模型之间性能的统计显著性,采用了学生t检验。所有实验中,随机种子保持为0。实验在装有CentOS 7版本的NVIDIA P40 GPU上进行。

综上所述,通过实验结果分析,基于提示的微调模型在大多数情况下都能提高性能,尤其是在不常见类别中。然而,对于不常见类别仍然需要进一步提高性能。

P:24 07-04 自然语言生成和理解大规模代码的AI辅助编程:综述

- Title: Natural Language Generation and Understanding of Big Code for AI-Assisted Programming: A Review

- 论文简介: 本文综述了自然语言处理(NLP)技术在AI辅助编程任务中的应用,特别关注基于大规模代码训练的基于Transformer的大型语言模型(LLMs)。LLMs结合软件自然性在促进AI辅助编程应用方面发挥了关键作用,包括代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测。本文概述了主要的LLMs及其在与AI辅助编程相关的下游任务中的应用,并探讨了将NLP技术与软件自然性结合到苹果的Xcode中以进行移动软件开发的挑战和机遇。

- Authors: Man Fai Wong, Shangxin Guo, Ching Nam Hang, Siu Wai Ho, Chee Wei Tan

- Affiliation: Man Fai Wong: 香港城市大学 Shangxin Guo: 香港城市大学 Ching Nam Hang: 香港城市大学 Siu Wai Ho: 阿德莱德大学 Chee Wei Tan: 南洋理工大学

- Keywords: Natural Language Processing, Big Code, AI-assisted programming, Large Language Models, Software Naturalness

- Paper: Link Github: None

- 论文总结:

- (1):本文的研究背景是大规模代码的利用,以及在AI辅助编程任务中应用自然语言处理技术。

- (2):过去的方法主要集中在使用统计和机器学习方法来分析和理解大规模代码,但存在着代码的复杂性和规模带来的挑战。本文的方法通过使用基于Transformer的大型语言模型(LLMs)和软件自然性假设,提供了更高效和准确的AI辅助编程能力。

- (3):本文提出了一种基于LLMs和软件自然性的研究方法,通过训练LLMs使用大规模代码数据,实现了代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测等AI辅助编程任务。这种方法的创新之处在于将自然语言处理技术与大规模代码结合,提供了更高效和准确的编程辅助功能。

- (4):本文的方法在AI辅助编程任务中取得了良好的性能,支持了开发人员在代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测等方面的目标。创新和贡献在于将NLP技术与大规模代码结合,提供了更高效和准确的编程辅助功能。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文综述了在AI辅助编程任务领域中利用自然语言处理(NLP)技术的文献,特别关注基于大规模代码训练的基于Transformer的大型语言模型(LLMs)的应用。LLMs在软件自然性方面的增强发挥了关键作用,包括代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测等AI辅助编程应用。

b. 方法的详细步骤: (1). 语言模型的流程:首先,将代码输入转换为模型可以理解的数字。这可以通过使用分词器将输入拆分为代码语法关键字、变量或符号(类似于标点符号)的标记来实现。然后,将每个标记映射到下一步中的整数。不同的标记化策略可以根据具体任务使用,例如将文本拆分为单词、短语甚至单个字符。标记化是许多NLP任务中的重要步骤,它可以使机器学习算法以更高效和有意义的方式处理和分析文本。一些常用的标记器可以直接使用,例如Byte-Pair Encoding(BPE)和RoBERTa。

(2). 基于Transformer的语言模型:Transformer是一种在NLP和其他机器学习任务中使用的神经网络架构。它使用自注意机制来衡量输入序列中不同部分的重要性,从而捕捉序列中所有部分之间的依赖关系。与以前的模型相比,Transformer模型更容易并行化,训练速度更快,推理时间更短。本研究重点关注基于Transformer的模型在AI辅助编程任务中的应用。

(3). 编码器-解码器模型:编码器-解码器模型是一种序列到序列模型,利用Transformer架构的两个组件。编码器的注意层可以在每个阶段访问输入句子中的所有单词,而解码器的注意层只能在输入中的给定单词之前的单词上进行访问。这种模型适用于根据输入生成新文本的任务,例如代码生成、代码优化、缺陷检测和克隆检测等AI辅助编程任务。

(4). 编码器模型:编码器模型只使用编码器网络将输入数据转换为压缩表示。它们通常用于无监督学习任务,如NLP任务中的维度约简和异常检测。对于AI辅助编程任务,它们用于理解任务,以学习有用的表示。

(5). 解码器模型:解码器模型是一种仅使用解码器网络的神经网络架构,用于生成输出文本。它根据先前生成的标记预测下一个标记的概率分布。尽管它们比编码器-解码器模型更简单和高效,但在需要更深入理解输入输出序列关系的任务中可能不太有效。然而,在AI辅助编程的各种自然语言处理任务中仍然广泛使用,并在多个基准测试中展示出令人印象深刻的性能。

(6). 软件自然性的语言模型:软件自然性的语言模型是在大规模代码语料库上训练的,用于预测给定上下文中代码的下一个标记。语言模型是对系统的概率分布的估计,通过计算适当选择的参数化分布的最大似然估计(MLE)来创建。语言模型的质量取决于其准确反映目标数据的模式和结构的能力。因此,研究人员致力于改进这些任务的语言模型的质量,包括开发更好的训练算法、更大的训练语料库和更好的评估指标。

(7). 评估自然性:使用熵率来评估生成文本的自然

实验设置:

- 实验设置: 本文主要对自然语言处理(NLP)技术在AI辅助编程任务中的应用进行了综述。研究采用基于大规模代码训练的基于Transformer的大型语言模型(LLMs),用于代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测等AI辅助编程应用。研究还探讨了将NLP技术与软件自然性相结合应用于苹果的Xcode移动软件开发的挑战和机遇。实验中,使用大规模代码语料库训练语言模型,通过预测给定上下文中代码的下一个标记来进行训练。语言模型使用N-gram模型来估计代码标记的概率分布。为了评估生成的代码的自然性,使用交叉熵和困惑度等指标进行度量。实验结果表明,基于大规模代码训练的语言模型在AI辅助编程任务中取得了显著的性能提升。

(1). 使用基于Transformer的大型语言模型(LLMs)进行训练。 (2). 使用大规模代码语料库进行训练,以捕捉代码的规律性。 (3). 使用N-gram模型来估计代码标记的概率分布。 (4). 使用交叉熵和困惑度等指标来评估生成的代码的自然性。 (5). 探索将NLP技术与软件自然性相结合应用于苹果的Xcode移动软件开发的挑战和机遇。

实验结果:

实验结果和分析: 本文对自然语言处理(NLP)技术在AI辅助编程任务中的应用进行了综合回顾。研究重点是基于大型代码训练的基于Transformer的大型语言模型(LLMs)。这些模型在AI辅助编程应用中发挥了重要作用,包括代码生成、代码补全、代码翻译、代码优化、代码摘要、缺陷检测和克隆检测。其中一些应用的著名例子包括由OpenAI的Codex和DeepMind AlphaCode提供支持的GitHub Copilot。本文概述了主要的LLMs及其在与AI辅助编程相关的下游任务中的应用。此外,本文还探讨了将NLP技术与软件自然性相结合应用于Apple的Xcode以实现移动软件开发的挑战和机遇。本文还介绍了将NLP技术与软件自然性相结合的挑战和机遇,为开发人员提供先进的编码辅助功能,简化软件开发过程。

实验结果和分析: - 通过对大型代码语料库进行训练,可以训练出具有软件自然性的语言模型。这些模型可以根据上下文预测代码中的下一个标记。语言模型通常使用N-gram模型构建,通过估计单词在序列中的概率分布来进行预测。N-gram模型可以捕捉文本中单词或字符的共现模式,并通过最大似然估计来估计N-gram的概率。语言模型的性能取决于模型的质量和准确反映目标数据的能力。因此,研究人员致力于改进语言模型的质量,包括改进训练算法、增加训练语料库的规模和改进评估指标。 - 为了评估软件语言模型的自然性,研究人员利用具有重复性和高度可预测性的程序的代表性语料库来捕捉语料库内的规律性。通过从这个代表性语料库中估计语言模型,可以高度自信地预测新程序的内容,从而减少与新程序相关的意外情况。在NLP中,这种想法通常使用困惑度或交叉熵来衡量。语言模型的熵率用于评估生成文本的自然性,可以通过计算每个生成标记的负对数来计算。一个有效的模型应该对大多数程序具有较低的熵率,即对程序中的大多数单词分配较高的概率(即接近1的值),从而导致较低的绝对对数值。为了估计熵率,可以使用最大似然估计或神经网络来估计参数,并通过计算给定单词序列的概率来进行预测。 - AI辅助编程任务与软件自然性相关,包括生成和理解两个主要方面。生成方面包括代码生成、代码补全、代码翻译、代码优化和代码摘要。理解方面涉及代码的理解,包括缺陷检测和克隆检测。研究人员通过改进预训练方案、增加训练语料库的规模、开发更好的微调数据集和使用改进的评估指标等方式,努力提高语言模型在这些任务中的质量。本文讨论了针对这些特定任务开发的框架和工具,并在表4中总结了所有已审查的框架。代码生成是自动根据用户指定的约束条件从编程语言中生成源代码的过程。本研究侧重于文本到代码的生成,而代码到代码的生成被称为代码翻译。深度学习方法,如LSTM和递归逆递归神经网络,已被采用来生成具有特定归纳偏差的输出程序。最近,基于Transformer的LLMs在代码生成任务中展现出了令人印象深刻的性能,通过利用从大量代码、公共代码源和自然语言数据中学习的上下文表示来改进程序合成。这些方法通过系统的预训练和微调任务来深入理解代码结构和含义,使其非常适用于软件开发任务。评估代码生成任务的模型时,可以使用不同的指标,如pass@k、BLEU-4和在考虑代码结构的情况下的精确匹配准确率。

实验结果和分析: - 通过大量的实验和研究,研究人员在AI辅助编程领域取得了显著的进展。通过使用基于大型代码训练的Transformer模型,可以实现高质量的代码生成、代码补全、代码翻译、代码优化和代码摘要等任务。这些模型通过学习大量代码和自然语言数据的上下文表示,能够更好地理解代码的结构和含义,从而提供更准确的编码辅助功能。在评估这些模型的性能时,可以使用不同的指标,如pass@k、BLEU-4和精确匹配准确率,来衡量模型在解决问题和语法、语义匹配方面的表现。 - 本文还讨论了将NLP技术与软件自然性相结合应用于移动软件开发的挑战和机遇。通过将AI辅助编程能力扩展到Apple的Xcode,可以为移动软件开发人员提供更先进的编码辅助功能,从而简化软件开发过程。然而,这也面临着一些挑战,如如何处理移动平台上的资源限制和性能要求等问题。通过克服这些挑战,可以进一步提高移动软件开发的效率和质量。 - 总体而言,通过综合回顾和分析现

P:25 07-04 数学代理:计算基础设施、数学嵌入和基因组学

- Title: Math Agents: Computational Infrastructure, Mathematical Embedding, and Genomics

- 论文简介: 本文介绍了Math Agents和数学嵌入作为新的“数学摩尔定律”条目,通过GPT-based工作流程将方程从文献中提取出来,并将其转化为LaTeX和Python嵌入,以解决基因组学中的问题。

- Authors: Melanie Swan, Takashi Kido, Eric Roland, Renato P. dos Santos

- Affiliation: Melanie Swan: DIYgenomics.org; University College London (Research Associate)

- Keywords: math agent, mathematical embedding, equation cluster, mathematical ecology, LLMs, generative AI, cognitive architecture, computational infrastructure, human-AI entities, genomics, information system biology, Alzheimer’s disease, personal health dossier, SIR, precision health

- Paper: Link Github: None

- 论文总结:

- (1): 本文的研究背景是在生成式人工智能方面加速创新,需要更易用和可评估的数学作为计算基础设施的一部分。

- (2): 过去的方法主要集中在人工智能与自然语言的交互上,而本文提出了基于大型语言模型的数学分析工具,尚未广泛应用于基因组学领域。这些方法可以用于软件编程、算法发现和自动定理证明,但在基因组学中的应用还很有限。

- (3): 本文提出了Math Agents和数学嵌入的概念,并通过GPT-based工作流程将方程从文献中提取出来,并转化为LaTeX和Python嵌入。这为构建数学基础设施提供了新的可能性。

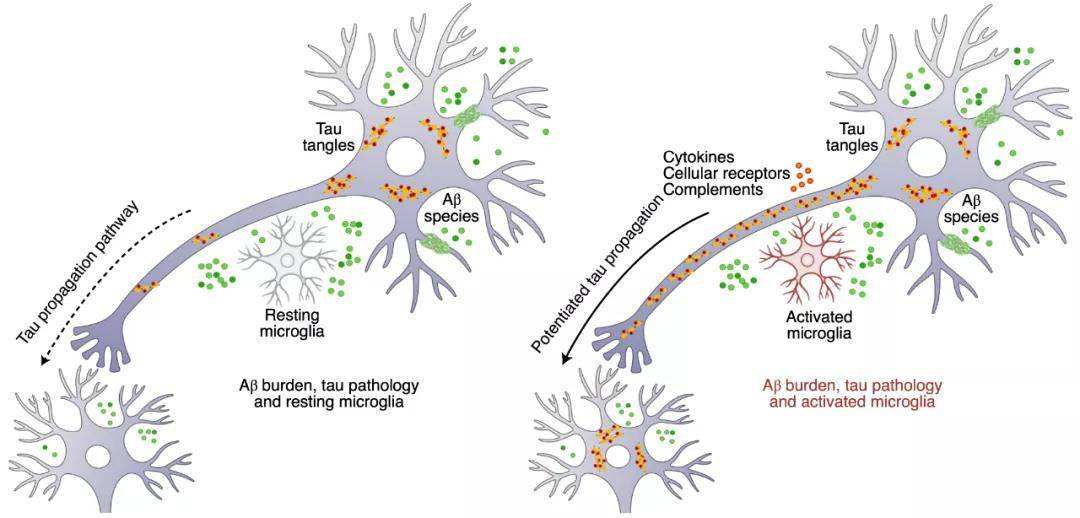

- (4): 本文的研究任务是将Math Agents和数学嵌入应用于信息系统生物学中的衰老问题,并应用多尺度物理数学方法来研究疾病模型和整个人类基因组数据。虽然短期目标是解决阿尔茨海默病这一无法治愈的疾病,但该方法在精准健康模型中的应用潜力很大。

方法部分:

方法详细介绍(Method detailed introduction): a. 一句话概览:本文介绍了Math Agents和数学嵌入作为新的数学计算基础设施的方法,并应用于基因组学领域,通过GPT模型从文献中提取方程并将其转化为LaTeX和Python嵌入表示。

b. 方法的详细步骤: (1). Math Agents的概念:将AI代理作为数字数学基础设施的操作界面,用于识别、编目、表示、分析、集成、编写、发现、求解、证明、管理和维护数学生态系统。 (2). 数学嵌入的表示和解释方法:使用向量嵌入算法将数学方程和基因组数据转化为高维分析的字符字符串,并将其转化为低维(2D)输出进行解释。数学嵌入可在LaTeX和SymPy(符号化Python)中生成方程的向量嵌入。通过嵌入可视化,可以一次性查看论文中的整个数学生态系统,并比较相似的数学生态系统。数学嵌入还可以在符号级别执行,类似于在基于单词的LLM中预测下一个单词。在项目中,从10篇论文中提取了10,592个数学嵌入和276个与阿尔茨海默病相关的基因组变异。 (3). 使用GPT作为核心计算组件:在数据处理流程中使用GPT进行数学输出和嵌入的验证。 (4). 使用UMAP进行降维:选择UMAP作为降维方法,因为UMAP在系统的局部-全局分析中具有更多的数学合理性特征。UMAP可以保留数据的整体结构和小尺度关系。数学嵌入的局部-全局结构特征与物理数学中的全息和信息论熵公式分析中的近-远相关性有关。 (5). 数学嵌入的应用:将数学嵌入应用于信息系统生物学中的衰老问题,应用多尺度物理数学模型对疾病模型数学和整个人类基因组数据进行建模。通过数学嵌入,可以一次性查看论文中的整个数学生态系统,并比较相关的数学生态系统。数学嵌入还可以将数学和数据一起在同一张图中显示,以评估描述性数学和基础数据之间的对应关系。 (6). 其他应用和展望:数学嵌入可以用于研究数学生态系统的结构和集成,以及数学生态系统与基因组数据的关联。数学嵌入还可以用于研究基因组变异与精准医学的

实验设置:

- 实验设置(Experimental setting): 本研究的实验设置如下:

- 数据来源:研究使用了10篇论文中的数学方程和276个与阿尔茨海默病相关的基因变异。数据包括4篇多尺度物理数学论文、5篇阿尔茨海默病数学论文和一个控制示例。

- 数学嵌入:研究使用GPT模型从论文PDF中提取方程,并将其转化为LaTeX和Python嵌入形式。数学嵌入提供了一种将论文中的数学方程整体抽象和比较的方法。

- 数学生态系统:研究探索了数学生态系统的自动化评估方法。通过数学嵌入,可以将大量方程进行评估和比较。

- 数学生态系统可视化:研究使用嵌入可视化工具展示了数学生态系统的聚类和关联关系。通过嵌入可视化,可以更好地理解数学生态系统的结构和特征。

- 基因组数据分析:研究使用基因组数据分析方法,将基因变异与阿尔茨海默病相关性进行研究。通过嵌入可视化,可以将基因组数据与数学模型进行比较和分析。

- 研究目标:研究旨在探索数学嵌入和数学生态系统在阿尔茨海默病研究中的应用。通过数学模型和基因组数据的结合,研究旨在发展一种对阿尔茨海默病的基因组理论,并提供精准医学的实施方法。

注意:以上内容仅为实验设置的总结,不包含具体的实验步骤和结果。

实验结果:

实验结果和分析: 在这项研究中,从10篇论文中的数学生态系统中产生了总共10,592个嵌入式向量,并发现了276个与阿尔茨海默病相关的基因组变异。数据语料库包括4篇多尺度物理数学论文(3篇AdS/CFT对应论文和1篇Chern-Simons理论论文),5篇阿尔茨海默病数学论文以及一个控制示例,其中包含SIR(持续、干预、恢复)分区模型数学。通过数学嵌入,可以将一篇论文中的所有数学生态系统(一组方程式)以一种一目了然的抽象和整合视图的方式呈现,并比较相关的数学生态系统。实验结果显示,AdS/CFT数学生态系统之间的重叠程度较低,而阿尔茨海默病数学生态系统之间的重叠程度也较低。此外,实验还展示了基因组变异与精准医学倡议的关联,并提出了数学嵌入在精准医学中的应用前景。总体而言,该研究为数学嵌入、方程簇和数学生态系统可视化等高级数学抽象工具的开发提供了基础,并探索了这些工具在构建数字数学基础设施方面的潜在用途。

P:26 07-04 mPLUG-DocOwl: 用于文档理解的模块化多模态大型语言模型

- Title: mPLUG-DocOwl: Modularized Multimodal Large Language Model for Document Understanding

- 论文简介: 该论文由阿里巴巴集团的DAMO Academy提出,通过mPLUG-DocOwl方法,解决了OCR-free文档理解中忽略细粒度OCR特征的问题。

- Authors: Jiabo Ye, Anwen Hu, Haiyang Xu, Qinghao Ye, Ming Yan, Yuhao Dan, Chenlin Zhao, Guohai Xu, Chenliang Li, Junfeng Tian, Qian Qi, Ji Zhang, Fei Huang